metadata

library_name: transformers

license: cc

language:

- ja

- en

base_model:

- llm-jp/llm-jp-3-13b

Model Card for Model ID

llm-jp-3-13bモデルをichikaraデータセットでSFTしたモデルです。

アップロードされているファイルはLoraアダプタのみです。

HF_TOKEN, WB_TOKENはご自身のものに書き換えてください。

How to Get Started with the Model

- Jupyter Notebook Training-Inference-code.ipynb

- Training Dataset ichikara-instruction-003-merge.json

- Test Dataset ELYZA-tasks-100-TV (not included)

File Tree

/workspace

|--Training-Inference-code.ipynb

|--models/models--llm-jp--llm-jp-3-13b/snapshots/cd3823f4c1fcbb0ad2e2af46036ab1b0ca13192a

|--ichikara-instruction-003-merge.json

`--elyza-tasks-100-TV_0.jsonl

Training Details

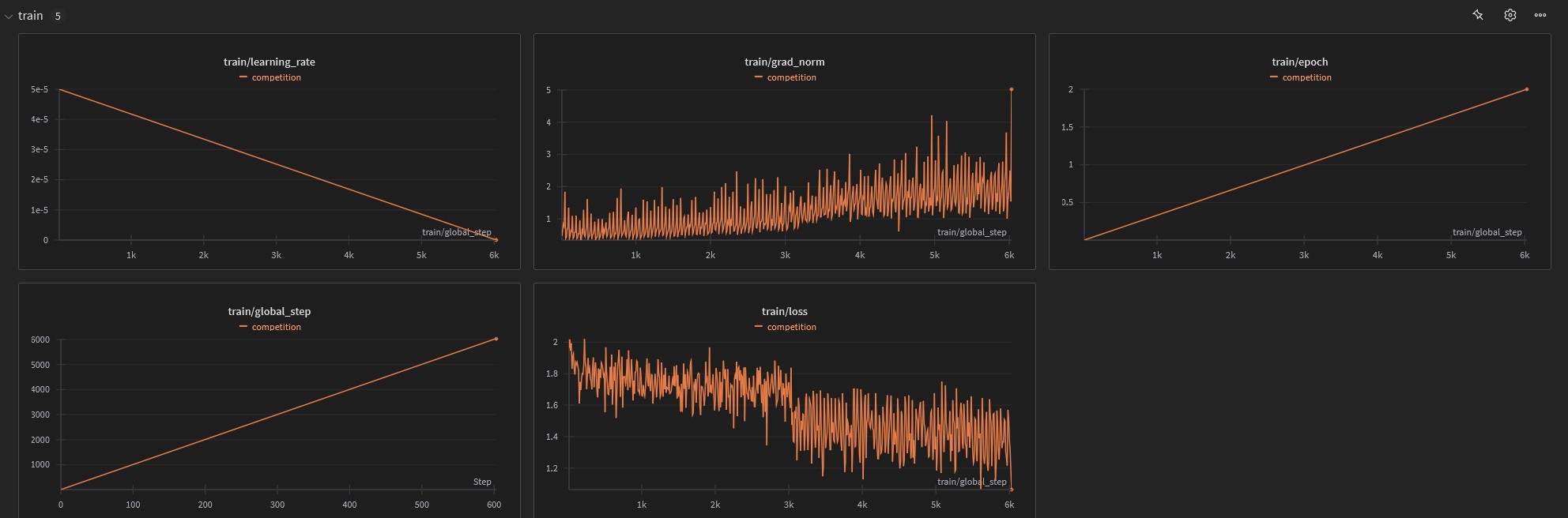

training_arguments = TrainingArguments(

output_dir=new_model_id,

per_device_train_batch_size=1,

gradient_accumulation_steps=2,

optim="paged_adamw_32bit",

num_train_epochs=2,

logging_strategy="steps",

logging_steps=10,

warmup_steps=10,

save_steps=100,

save_total_limit = 2,

max_steps = -1,

learning_rate=5e-5,

fp16=False,

bf16=True,

seed = 1001,

group_by_length=True,

report_to="wandb"

)

Training Results

Training Time: 5:52:48

Total steps: 6030 steps

Epoch: 2

Training Dataset

- LMのための日本語インストラクションデータ(ichikara-instruction)

https://liat-aip.sakura.ne.jp/wp/llm

のための日本語インストラクションデータ作成/llmのための日本語インストラクションデータ-公開/

関根聡, 安藤まや, 後藤美知子, 鈴木久美, 河原大輔, 井之上直也, 乾健太郎. ichikara-instruction: LLMのための日本語インストラクションデータの構築. 言語処理学会第30回年次大会(2024)

上記datasetをすべてマージし、IDを連番になるよう振りなおしています。

LICENCE: CC-BY-NC-SA

Hardware

Google Cloud Platform

L4 GPU 24GB

RAM 48GB

Software

transformers==4.46.3

trl==0.12.2

Others: latast