text

stringlengths 20

1.01M

| url

stringlengths 14

1.25k

| dump

stringlengths 9

15

⌀ | lang

stringclasses 4

values | source

stringclasses 4

values |

|---|---|---|---|---|

# Локализуем приложение на React Native

В ходе разработки одного из наших приложений нам понадобилось сделать поддержку мультиязычности. Задача была дать пользователю возможность менять язык (русский и английский) интерфейса приложения. При этом текста и контент должны переводиться «на лету».

Для этого нам нужно было решить 2 задачи:

1. Определить текущий язык приложения.

2. Использование глобального состояния для перевода «на лету».

В этой статья попробую подробно расписать как мы решили данные задачи. И так поехали.

Определяем текущий язык устройства

----------------------------------

Для определения текущего языка можно, конечно, воспользоваться библиотекой react-native-i18n, но мы решили обойтись без него, так как для решения этой задачи можно и без сторонних библиотек. Для этого пишем следующее:

```

import {NativeModules, Platform} from 'react-native';

let deviceLanguage = (Platform.OS === 'ios'

? NativeModules.SettingsManager.settings.AppleLocale ||

NativeModules.SettingsManager.settings.AppleLanguages[0] // iOS 13

: NativeModules.I18nManager.localeIdentifier

```

Для ios мы извлекаем язык приложения через SettingsManager, а для android через нативный I18nManager.

Теперь когда мы получили текущий язык устройства, мы можем сохранить его в AsyncStorage и приступить ко второй задаче.

Переводим «на лету»

-------------------

Для управления глобальным состоянием мы используем MobX, но вы можете использовать другое решение.

И так мы должны создать класс(мне нравится называть «модель»), который будет отвечать за глобальное состояния текущей локализации. Создаем:

```

// ключ локального хранилища, в котором будем записывать текущий lang

const STORE = '@lang-store';

// список русскоязычных стран

const RU_LANGS = [

'ru',

'az',

'am',

'by',

'ge',

'kz',

'kg',

'md',

'tj',

'tm',

'uz',

'ua',

];

class LangModel {

@observable

lang = 'ru'; // по умолчанию

constructor() {

this.init();

}

@action

async init() {

const lang = await AsyncStorage.getItem(STORE);

if (lang) {

this.lang = lang;

} else {

let deviceLanguage: string = (Platform.OS === 'ios'

? NativeModules.SettingsManager.settings.AppleLocale ||

NativeModules.SettingsManager.settings.AppleLanguages[0] // iOS 13

: NativeModules.I18nManager.localeIdentifier

).toLowerCase();

if (

RU_LANGS.findIndex((rulang) => deviceLanguage.includes(rulang)) === -1

) {

this.lang = 'en';

}

AsyncStorage.setItem(STORE, this.lang);

}

}

export default new LangModel();

```

При инициализации нашей модели мы вызываем метод init, который берет локаль либо из AsyncStorage, если там есть, либо извлекаем текущий язык устройства и кладет в AsyncStorage.

Далее нам нужно написать метод(action), который будет менять язык:

```

@action

changeLang(lang: string) {

this.lang = lang;

AsyncStorage.setItem(STORE, lang);

}

```

Думаю, что тут все понятно.

Теперь самое интересное. Сами переводы мы решили хранить простым словарем. Для этого создадим js файл рядом с нашей LangModel, в котором мы поместим наши переводы:

```

// translations.js

// Да, за основу мы взяли русский.

export default const translations = {

"Привет, Мир!": {en: "Hello, World!"},

}

```

Далее реализуем еще один метод в LangModel, который будет принимать на вход текст и возвращать текст текущей локализации:

```

import translations from './translations';

...

rk(text) {

if (!text) {

return text;

}

// если локаль ru, то переводить не нужно

if (this.lang === 'ru') {

return text;

}

// если перевода нет, кинем предупреждение

if (translations[text] === undefined || translations[text][this.lang] === undefined) {

console.warn(text);

return text;

}

return translations[text][this.lang];

}

```

Все, наш LangModel готов.

**Полный код LangModel**

```

import {NativeModules, Platform} from 'react-native';

import {observable, action} from 'mobx';

import AsyncStorage from '@react-native-community/async-storage';

import translations from './translations';

const STORE = '@lang-store';

// список ru локали

const RU_LANGS = [

'ru',

'az',

'am',

'by',

'ge',

'kz',

'kg',

'md',

'tj',

'tm',

'uz',

'ua',

];

class LangModel {

@observable

lang = 'en';

constructor() {

this.init();

}

@action

async init() {

// Берем текущую локаль из AsyncStorage

const lang = await AsyncStorage.getItem(STORE);

if (lang) {

this.lang = lang;

} else {

let deviceLanguage: string = (Platform.OS === 'ios'

? NativeModules.SettingsManager.settings.AppleLocale ||

NativeModules.SettingsManager.settings.AppleLanguages[0] // iOS 13

: NativeModules.I18nManager.localeIdentifier

).toLowerCase();

if (

RU_LANGS.findIndex((rulang) => deviceLanguage.includes(rulang)) > -1

) {

this.lang = 'ru';

}

AsyncStorage.setItem(STORE, this.lang);

}

@action

changeLang(lang: string) {

this.lang = lang;

AsyncStorage.setItem(STORE, lang);

}

rk(text) {

if (!text) {

return text;

}

// если локаль ru, то переводить не нужно

if (this.lang === 'ru') {

return text;

}

// если перевода нет, кинем предупреждение

if (translations[text] === undefined || translations[text][this.lang] === undefined) {

console.warn(text);

return text;

}

return translations[text][this.lang];

}

}

export default new LangModel();

```

Теперь мы можем использовать метод rk для локализация текста:

```

{LangModel.rk("Привет, Мир!")}

```

Посмотреть как это работает можно в нашем приложении в [AppStore](https://apps.apple.com/ru/app/%D1%81%D0%BC%D0%BE%D1%82%D1%80%D0%B8-%D0%B3%D0%B8%D0%BC%D0%BD%D0%B0%D1%81%D1%82%D0%B8%D0%BA%D0%B0-%D0%B4%D0%BB%D1%8F-%D0%B3%D0%BB%D0%B0%D0%B7/id1529146888) и [Google Play](https://play.google.com/store/apps/details?id=webgev.look) (Нажать на иконку (!) справа вверху, пролистать вниз)

Бонус

-----

Конечно, писать каждый раз LangModel.rk это не круто. Поэтому мы можем создать собственный компонент Text и в нем уже использовать LangModel.rk

```

//components/text.js

import React from 'react';

import {Text} from 'react-native';

import {observer} from 'mobx-react';

import {LangModel} from 'models';

export const MyText = observer((props) => (

{props.notTranslate ? props.children : LangModel.rk(props.children)}

));

```

Так же нам может понадобиться, например, менять логотип приложения в зависимости от текущей локализации. Для этого можно просто менять контент в зависимости от LangModel.lang (не забудьте обернуть ваш компонент в observer(MobX))

**P.S.:** Возможно такой подход вам покажется не стандартным, но он нам понравился больше чем то, что предлагает [react-native-i18n](https://github.com/AlexanderZaytsev/react-native-i18n)

На этом у меня все. Всем спасибо!) | https://habr.com/ru/post/518672/ | null | ru | null |

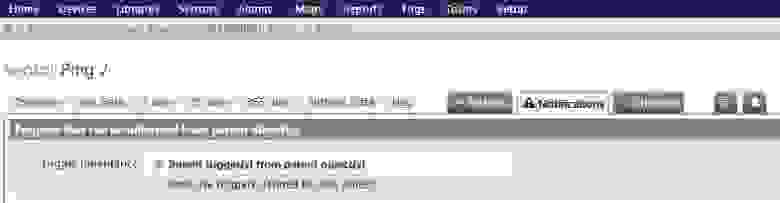

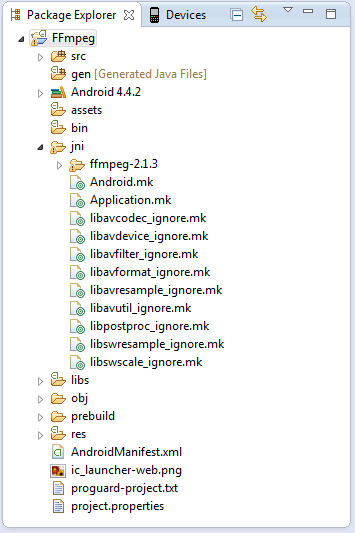

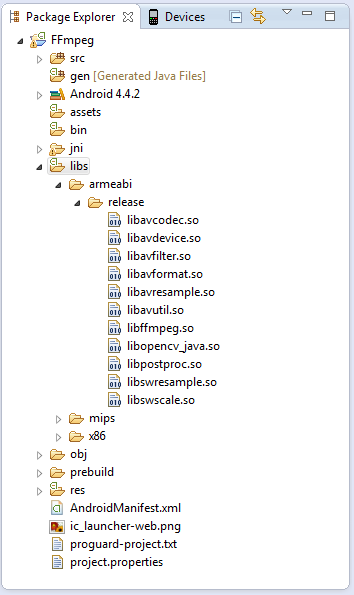

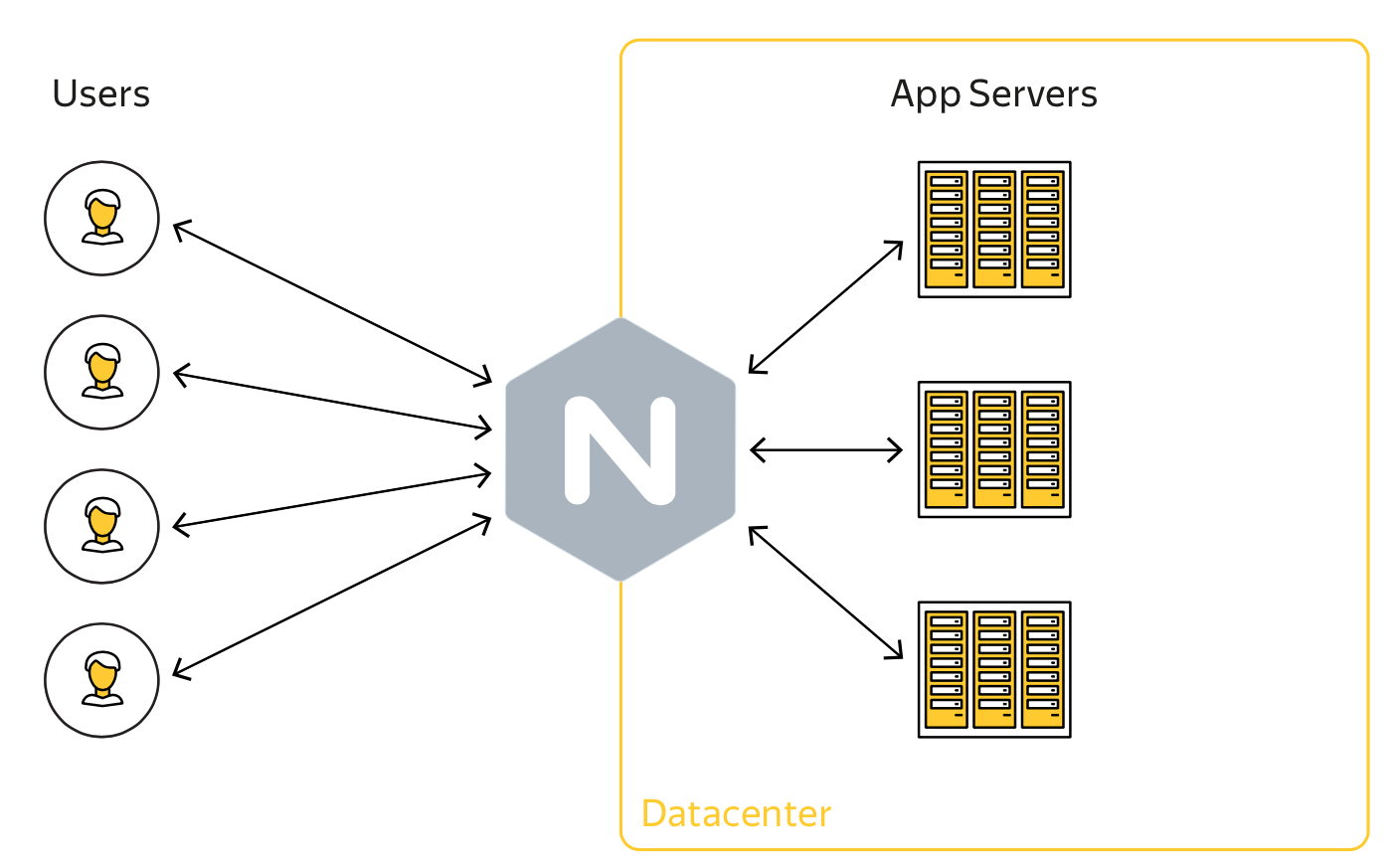

# ObjectManager в API Яндекс.Карт. Как быстро отрисовать 10 000 меток на карте и не затормозить всё вокруг

Перед разработчикам, которые используют API Яндекс.Карт, довольно часто встаёт задача отобразить много объектов на карте. Действительно много — порядка 10 000. Причем эта задача актуальна и для нас самих — попробуйте поискать аптеки на Яндексе. На первый взгляд кажется: «А в чем собственно проблема? Бери да показывай». Но пока не начнешь этим заниматься, не поймешь, что проблем на самом деле целый вагон.

[](http://habrahabr.ru/company/yandex/blog/243665/)

Вопросы по большому количеству меток с завидной регулярностью поступают в наш клуб и техподдержку. Кто все эти люди? Кому может быть интересно показать на карте больше 10 меток? В этом посте я подробно рассмотрю весь вагон проблем и расскажу, как в API появились инструменты, помогающие разработчикам оптимально показать большое количество объектов на карте.

В основном с проблемой сталкиваются информационные сервисы, которые хотят привязать данные к карте. Например сайт bankomator.ru рассказывает пользователям, где найти банкомат нужного банка.

Также от большого количества данных страдают ресурсы, посвященные недвижимости. Яркий пример – Cian.ru.

Мы сами внутри Яндекса до недавнего времени советовали смежным командам различные «хаки» и приемы для показа множества точек через API. Яркие примеры – Яндекс.Недвижимость и Яндекс.Такси.

### Пункт 1. В чем собственно проблема?

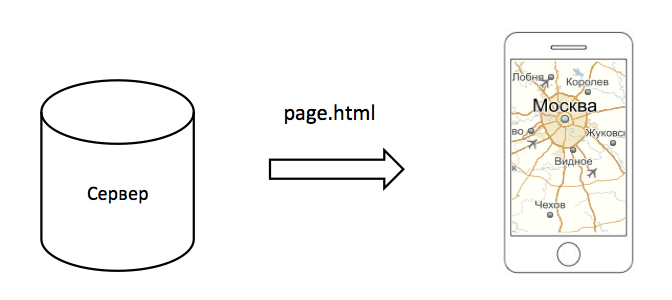

Чтобы прочувствовать на себе всю тяжесть поставленной задачи, нужно попробовать ее решить. Для начала давайте поймем, как показать карту на странице вашего сервиса. Рассмотрим простую схему:

Клиент (например, Safari на iPhone) запрашивает с сервера страницу index.html. Страница представляет собой документ вот с таким кодом:

```

ymaps.ready(init);

function init () {

var myMap = new ymaps.Map('map', {

center: [55.76, 37.64],

zoom: 10

});

}

```

Теперь усложняем задачу. У нас есть база данных, в которой хранятся адреса болельщиков «Зенита». И мы хотим показать на карте адреса этих болельщиков.

Решение задачи «в лоб»:

1. Делаем выборку из базы данных, получаем 1 млрд адресов.

2. Дописываем в файл index.html массив, содержащий весь миллиард адресов.

3. Передаем этот файл на клиент.

4. На клиенте перебираем данные массива и рисуем для каждого элемента метку на карте.

Если вы менеджер проекта, и ваш разработчик демонстрирует такое решение, скорее всего, вы поседеете. Вы выскажете ему свое оценочное суждение. Если убрать нецензурную брань, можно будет выделить следующие тезисы:

* Вес файла index.html увеличится до нескольких Мб и у пользователя страница будет открываться по несколько секунд.

* Зачем передавать на клиент ВСЮ базу, если нужно показать только метки для Москвы?

* Зачем рисовать на карте ВСЕ метки, если человек увидит только десятую их часть?

* Если на карте нарисовать около 100-200 меток обычным способом, карта будет тормозить.

* Можно загружать метки постепенно, пачками, чтобы канал не забивался и браузер успевал эти метки отрисовывать?

Мысль получает два направления:

1. Нужно уметь определять, какие данные видит пользователь и запрашивать только нужное.

2. Когда это нужное пришло, его надо оптимально отрисовать.

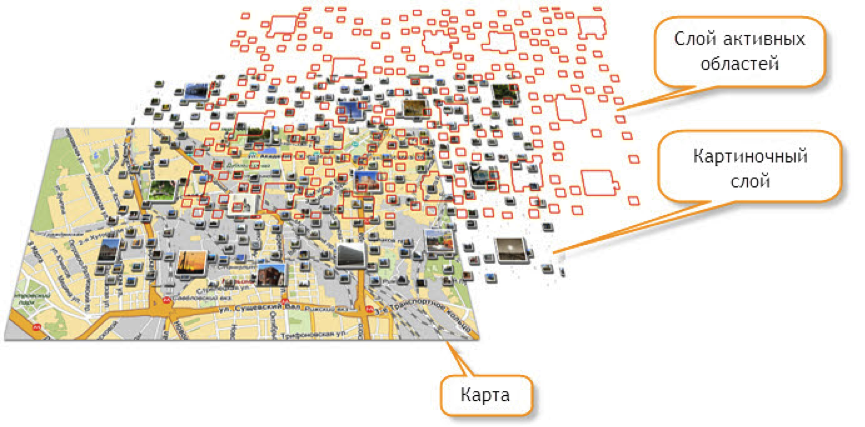

В API Яндекс.Карт сто лет назад был сделан инструмент для решения этих задач – технология активных областей. Кому интересно подробно, [почитайте руководство разработчика](https://tech.yandex.ru/maps/doc/jsapi/2.1/dg/concepts/hotspots/about-hotspots-docpage/).

Кратко – вы генерируете на сервере прозрачные картинки с метками плюс текстовое описание меток. Клиент может следить за видимой областью карты и запрашивать данные, которые нужны для текущей видимой области карты.

С помощью хотспотов, например, рисуются пробки на maps.yandex.ru. На этой же технологии сделан сайт bankomator.ru.

У этой технологии есть несколько существенных минусов

1. **Очень сложная серверная часть.** Попробуйте на досуге написать модуль, который генерирует вот такие картинки и их геометрические описания, и вы все поймете.

2. **Абсолютная негибкость.** Невозможно «приподнять» метку при наведении на нее курсора. Невозможно быстро поменять на клиенте внешний вид меток. Короче – на любой чих надо просить сервер перегенерировать картинку.

Поэтому пользователи крутились, как могли, без хотспотов – передавали наборы единичных объектов на клиент пачками, через таймаут. При этом на клиенте их снова ждали проблемы. Если вы передали на клиент 1000 точек, как их отрисовать?

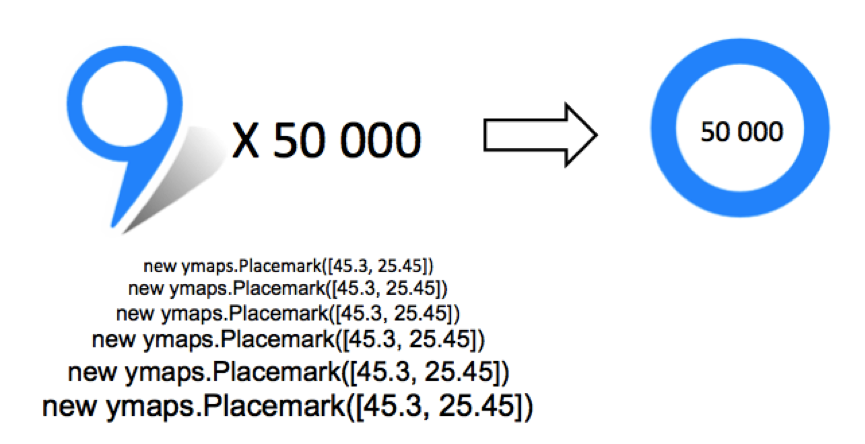

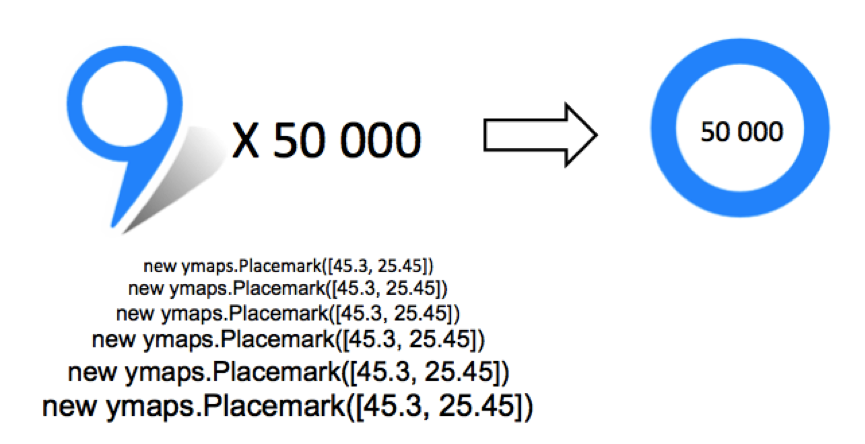

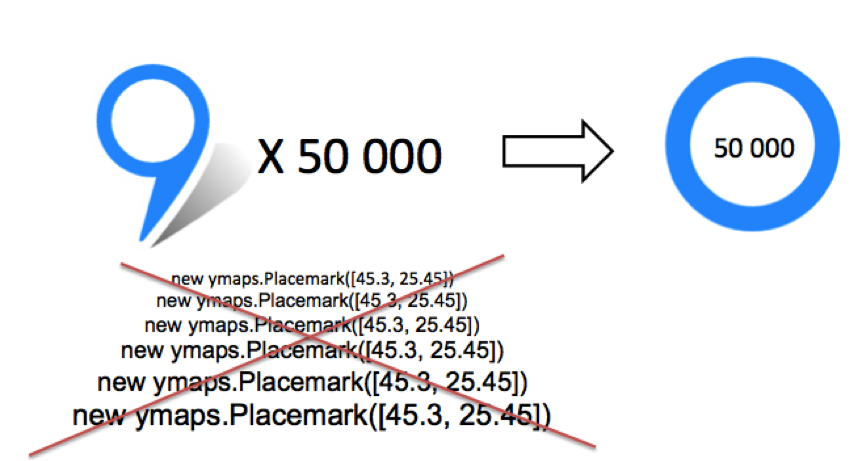

Из каждой точки нужно было сгенерировать объект `ymaps.Placemark` и добавить его на карту. Можно было добавить метки в кластеризатор (`ymaps.Clusterer`) и добавить откластеризованные метки на карту. Тут надо обратить внимание, что при кластеризации 10 000 точек нужно сначала эти 10 000 точек инстанцировать, а потом передать в кластеризатор. То есть метка может не показаться на карте, так как войдет в кластер, но мы все равно потратим время на ее инициализацию.

Подытожив все эти дела, мы решили написать модуль, который бы позволил:1. Быстро и легко отрисовать на клиенте большое количество точек.

2. Избежать лишних инициализаций при работе с точками на клиенте.

3. Загружать данные на клиент строго по требованию.

И мы это сделали. ~~Мы котики.~~

### Пункт 2. Рисуем метки быстро

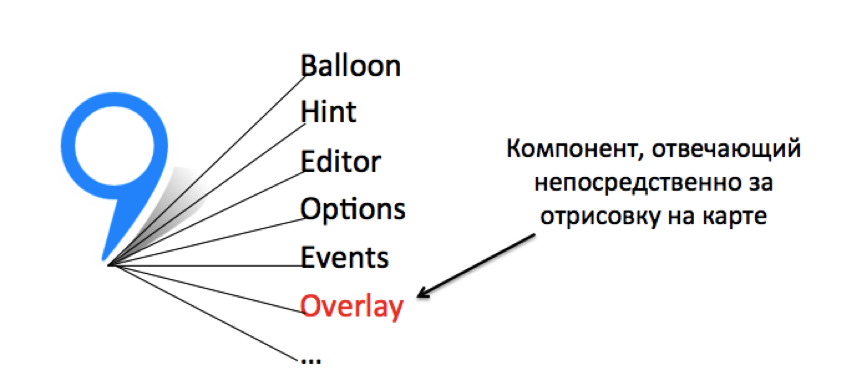

Чтобы научиться рисовать метки быстро, надо было понять, какие проблемы кроются в текущем, уже существующем решении. Давайте посмотрим, что может делать объект `ymaps.Placemark`:

1. Он умеет рисоваться на карте.

2. У него есть свой менеджер балуна `placemark.balloon.`

3. У него есть свой менеджер хинта `placemark.hint.`

4. У него есть редактор, который позволяет перетаскивать метку и фиксировать ее координаты `placemark.editor`.

Кроме того, метка динамически реагирует на любое изменение внешней среды – изменение опций, данных, проекции карты, смена масштаба карты, смена центра карты и многое, многое другое. Такие вот у нас могучие плейсмарки.

А нужна ли вся эта программная мощь для случая, когда разработчику просто нужно показать много однотипных меток на карте? Правильно, не нужна.

Поэтому первое озарение заключалось в следующем: а давайте вынесем все вспомогательные модули меток в один общий компонент и для каждого отдельного объекта будем создавать только программную сущность, которая непосредственно отвечает за отрисовку.

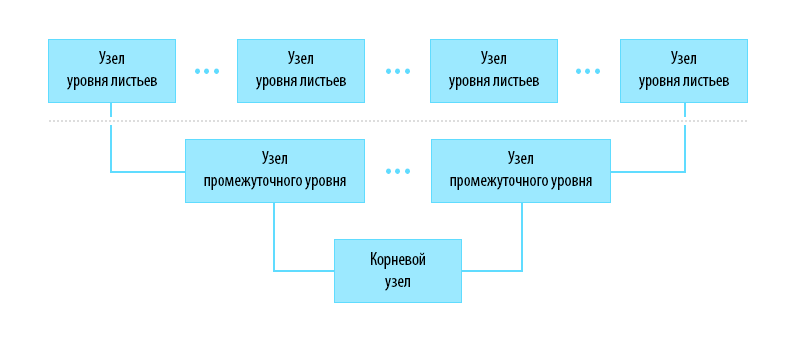

Второе озарение пришло, когда мы думали над проблемой лишних программных инициализаций. Вспоминаем рассказ выше, где-то в районе вот такой картинки.

Нам захотелось избавиться от лишних программных инициализаций, и мы придумали гениальное. Садитесь поудобнее, сейчас будет откровение: если вам мешают лишние программные инициализации – не делайте их.

Мы решили, что будем хранить пользовательские данные об объектах (по факту в JSON), а программные сущности для объектов будут создаваться только тогда, когда какой-либо объект нужно будет отрисовать на карте.

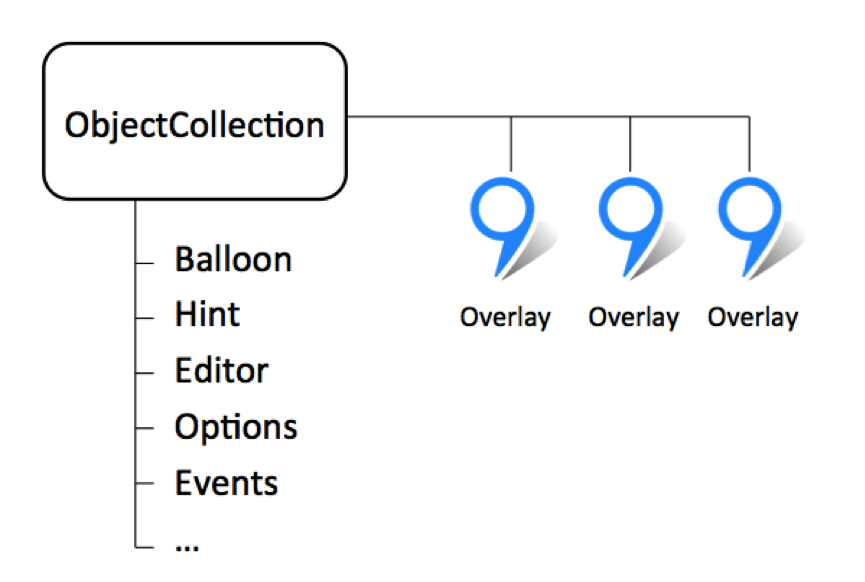

После комбинации этих идей и некоторой разработки родился новый модуль API для отображения большого количества точечных объектов – [ymaps.ObjectManager](https://tech.yandex.ru/maps/doc/jsapi/2.1/dg/concepts/object-manager/about-docpage/).

На вход этого менеджера скармливается JSON-описание объектов.

Менеджер анализирует, какие метки попадают в видимую область карты и либо рисует метки, либо кластеризует эти метки и показывает результат на карте.

Для отрисовки меток и кластеров на карте мы взяли только часть объекта `ymaps.Placemark` (а именно ymaps.overlay.\*), которая отвечала только за отображение метки на карте. Всю инфраструктуру типа балунов и хинтов мы вынесли в единый общий компонент.

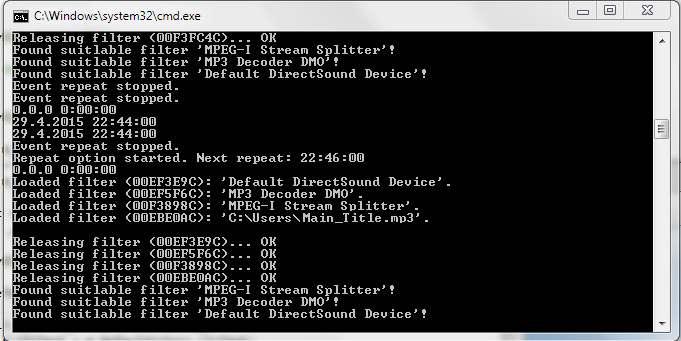

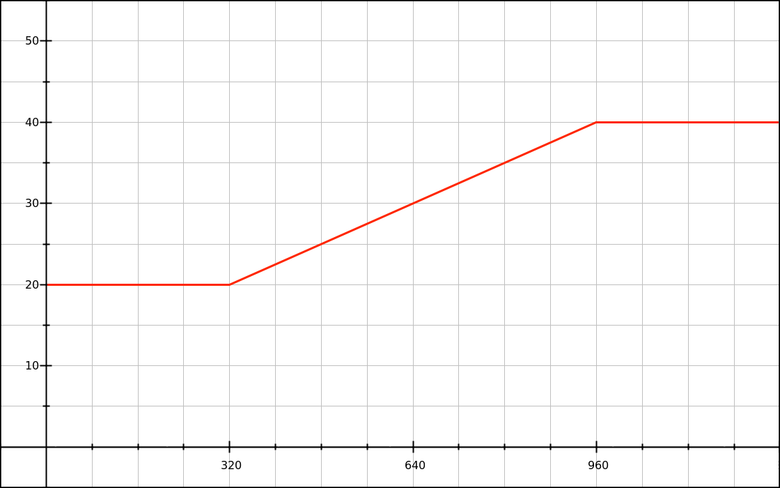

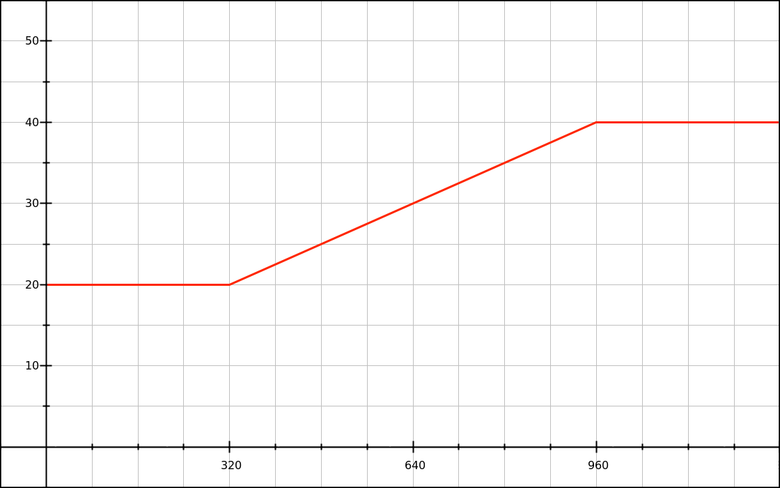

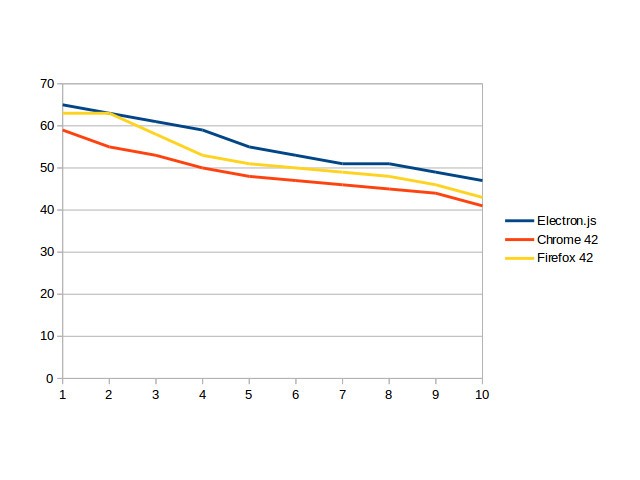

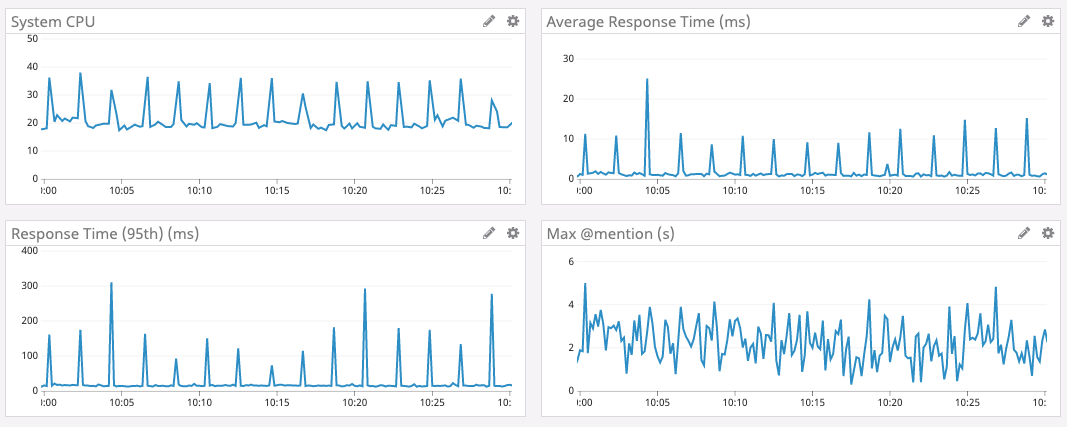

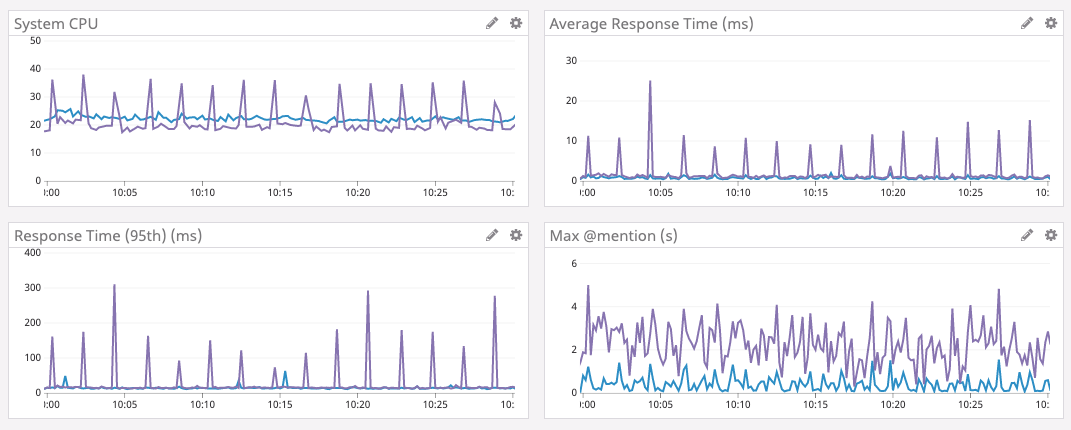

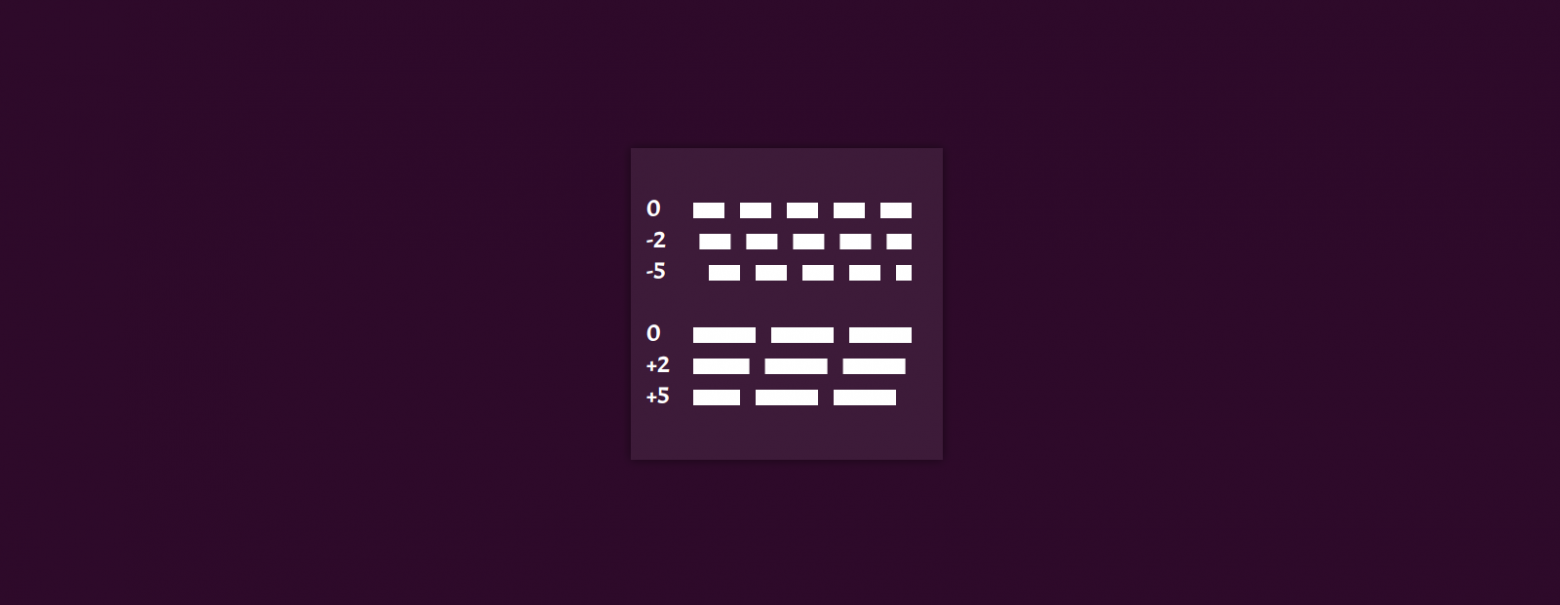

Эти приемы позволили нам неплохо продвинуться в вопросе отрисовки большого числа меток на клиенте. Вот какие мы получили приросты по скорости:

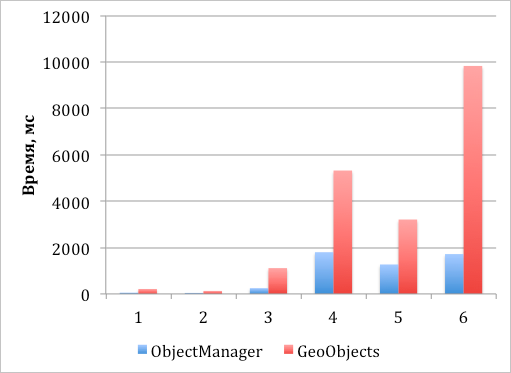

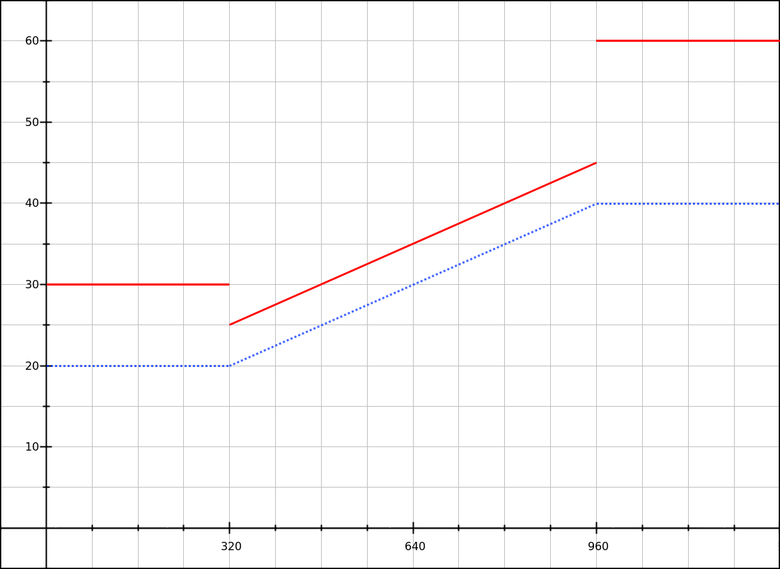

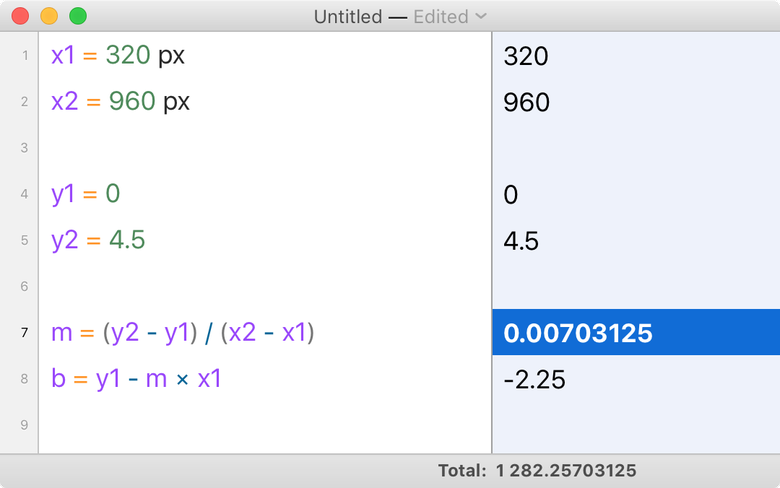

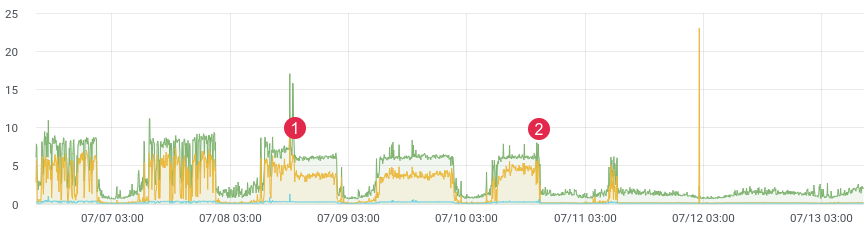

*График 1. Скорость создания и добавления объектов на карту с последующей асинхронной отрисовкой их видимой части*

1. Создание 1000 меток и добавление их на карту, все метки видны.

2. Создание 1000 меток и добавление их на карту с кластеризацией, все метки видны.

3. Создание 10000 меток и добавление их на карту с кластеризацией, все метки видны.

4. Создание 50 000 меток и добавление их на карту с кластеризацией, все метки видны.

5. Создание 50 000 меток и добавление их на карту с кластеризацией, видны 500 объектов.

6. Создание 50 000 меток и добавление их на карту без кластеризации, видны 10 000.

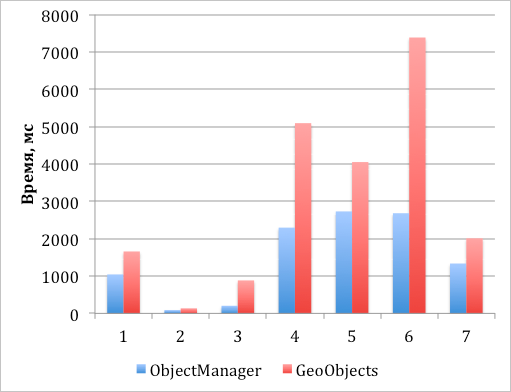

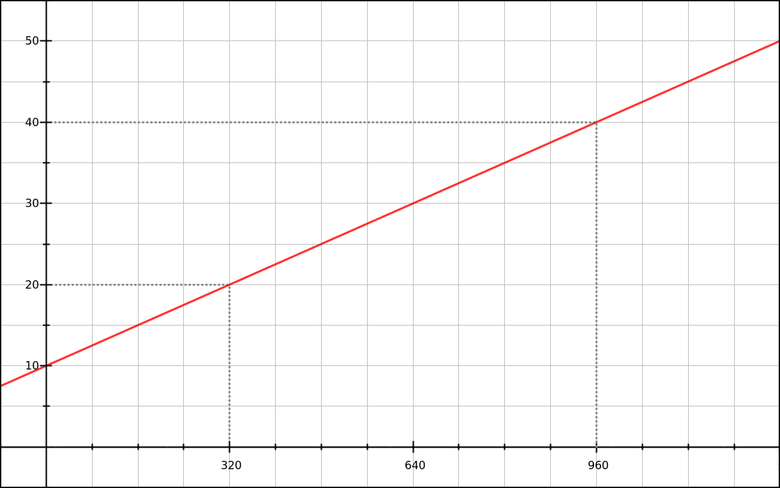

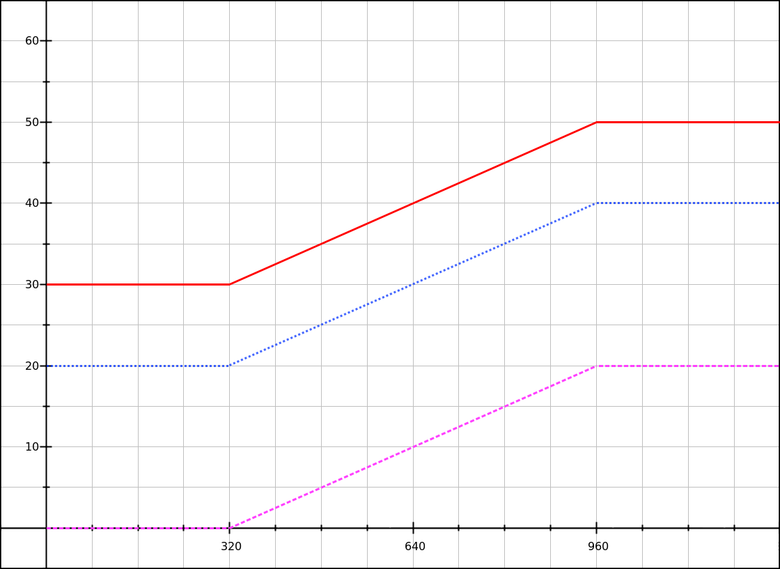

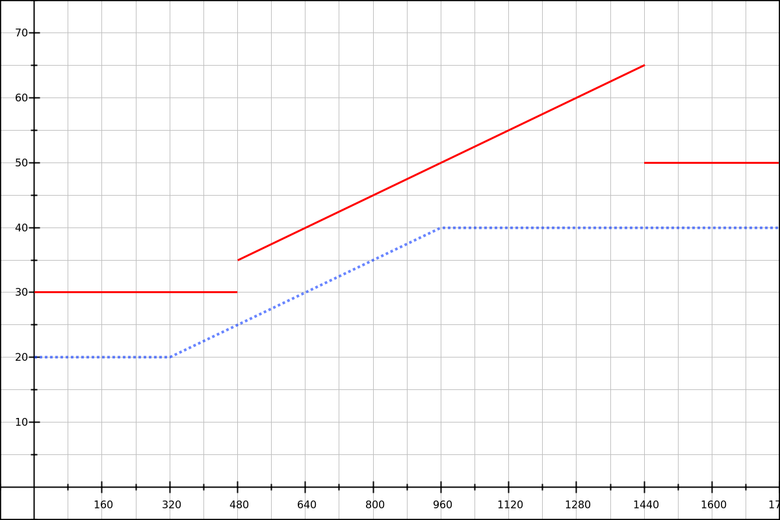

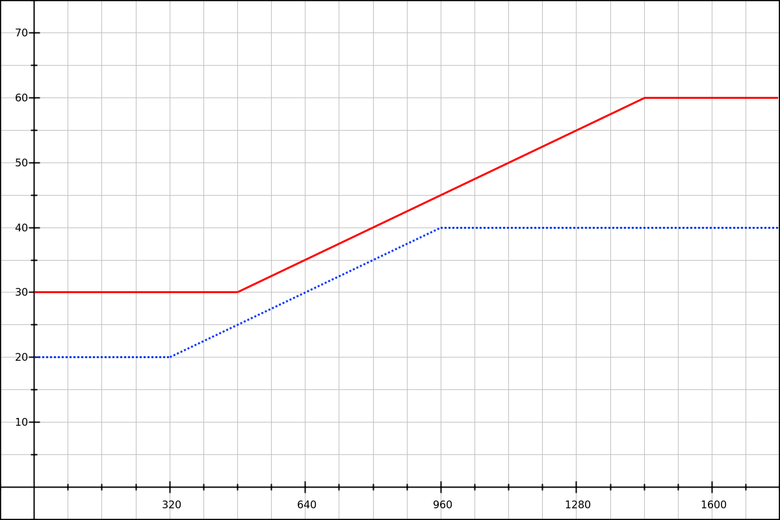

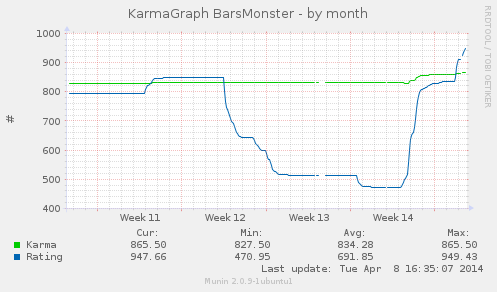

*График 2. Скорость создания и добавления объектов на карту с последующей синхронной отрисовкой их видимой части*

1. Создание 1000 меток и добавление их на карту, все метки видны.

2. Создание 1000 меток и добавление их на карту с кластеризацией, все метки видны.

3. Создание 10000 меток и добавление их на карту с кластеризацией, все метки видны.

4. Создание 50 000 меток и добавление их на карту с кластеризацией, все метки видны.

5. Создание 50 000 меток и добавление их на карту с кластеризацией, видны 500 объектов.

6. Создание 10 000 меток и добавление их на карту без кластеризации, видны 2000.

7. Создание 5000 меток и добавление их на карту без кластеризации, видны 1000.

**Важное замечание.** Вся эта статистика справедлива для современных браузеров. IE8 к числу этих браузеров не относится. Поэтому для него цифры будут значительно хуже, но думаю для большинства это не имеет значения.

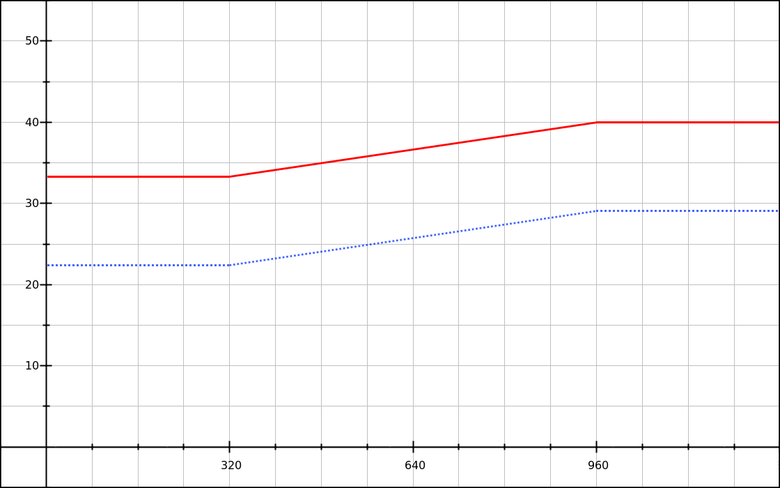

У нас получилось ускорить непосредственно создание и отрисовку объектов, вдобавок к этому мы максимально оптимизировали инициализацию программных сущностей. Теперь вы можете, например, откластеризовать на клиенте 50 000 точек, и работать с картой будет комфортно.

Почитать подробно про модуль можно в [нашем руководстве разработчика](https://tech.yandex.ru/maps/doc/jsapi/2.1/dg/concepts/object-manager/about-docpage/), а посмотреть вживую примеры работы модуля — в [песочнице](https://tech.yandex.ru/maps/jsbox/2.1/object_manager).

Итак, мы научились быстро-быстро рисовать и кластеризовать точки на клиенте. Что дальше?

### Пункт 3. Оптимально подгружаем данные

Помните пример про болельщиков «Зенита»? Мы решили проблему отрисовки данных на клиенте, но никак не решили проблему, связанную с оптимальной подгрузкой этих данных. Мы начали собирать типовые задачи пользователей API. По итогам исследований мы получили два типовых кейса:

1. У человека на сервере много данных, он хочет показывать их на клиенте, но подгружать данные по мере надобности.

2. Разработчик подготавливает данные на сервере (например, реализует серверную кластеризацию) и хочет показывать на клиенте результаты этой обработки.

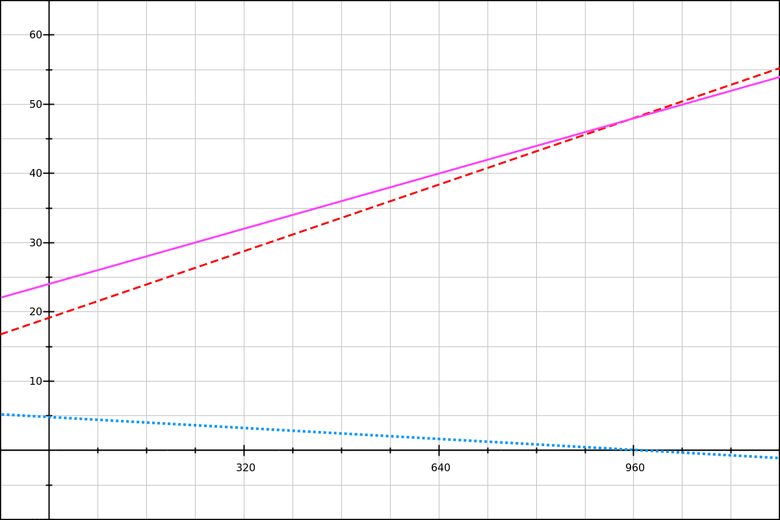

Для решения этих кейсов были написаны модули **LoadingObjectManager** и **RemoteObjectManager** соответственно.Оба модуля основаны по сути на реализации **ObjectManager**, но имеют ряд различий в алгоритме загрузки и кеширования загруженных данных.

В итоге по мере работы пользователя с картой ему будут приходить данные из вашей базы. В какой-то момент все или необходимая часть данных будут подгружены и запросы на сервер вообще перестанут отправляться.

Данные хранятся на клиенте в pr-дереве, поэтому выборки даже для большого количества данных делаются довольно шустро.

Теперь обсудим вариант номер два – отображение на клиенте результатов серверной кластеризации. Допустим, вы написали серверную кластеризацию меток. Также вы написали скрипт, который по запросу от клиента умеет отдавать кластеры и единичные метки, не вошедшие в состав кластера.

Вам остается только создать инстанцию **RemoteObjectManager** и прописать в нем путь до этого чудо-скрипта. **RemoteObjectManager** будет работать почти так же, как и **LoadingObjectManager**. Разница будет только в том, что мы будем перезапрашивать данные с сервера при каждой смене зума.

Поскольку данные кластеризуются на сервере, то сервер и только сервер может знать, какие данные нужно, а какие не нужно показывать в данный момент на карте. Поэтому информация об объектах хранится на клиенте только до первой смены зума, а потом все запрашивается заново.

Если с сервера передается описание метки-кластера, то на клиенте эти метки подцепят всю инфраструктуру из API – для кластеров нарисуются специальные значки, для них будут работать все стандартные поведения и так далее и тому подобное.

### Пункт 4. Размышления на тему серверной реализации

В этом разделе мы хотим перечислить концепции хранения и обработки данных на сервере, которые мы предполагали при проектировании клиентской части. Пойдём от простого к сложному.

#### 1. Хранение информации об объектах на сервере в статических файлах

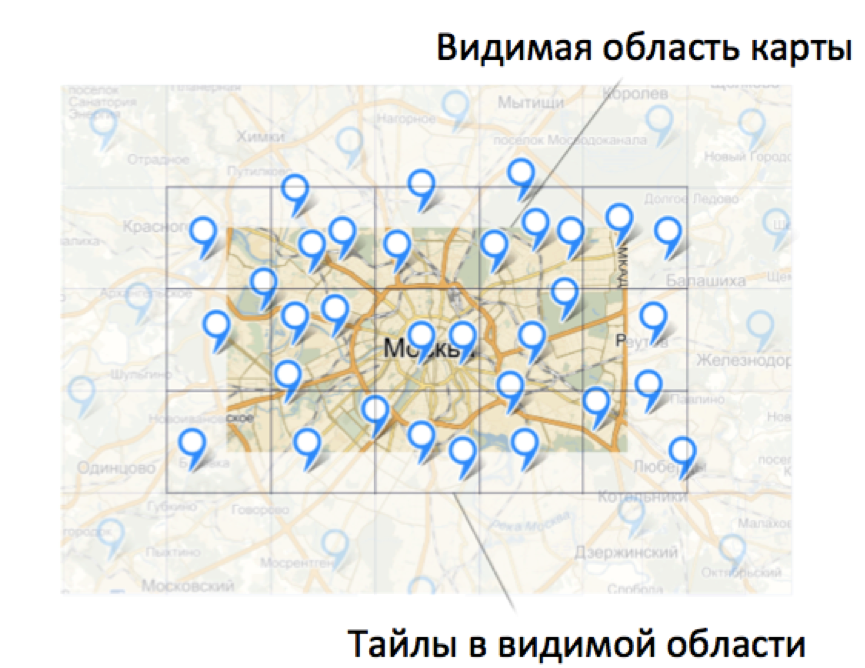

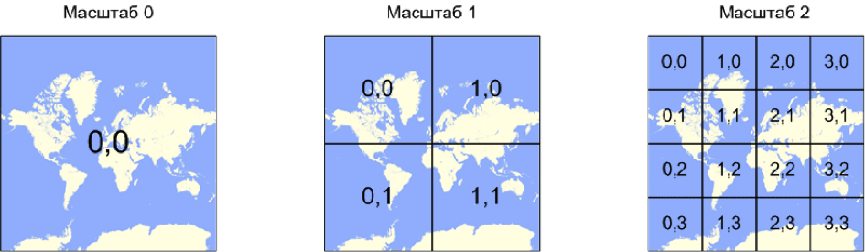

Клиентский код оперирует данными исключительно потайлово. Тайл – это некоторая нумерованная область на карте. Подробнее про нумерацию тайлов можно прочитать в нашей документации.

Когда на странице показывается некоторая область карты, клиентский модуль вычисляет, какие тайлы попали в эту видимую область, проверяет наличие нужных данных и отправляет запросы за данными по необходимости.

У клиентского модуля есть настройки, которые заставляют отправлять запросы за каждым новым тайлом по отдельности. Чем это ценно? Да тем, что мы получаем конечное число вариантов запроса клиента на сервер.

zoom=0, tile=[0, 0]

zoom=1, tile=[0, 0]

zoom=1, tile=[0, 1]

zoom=1, tile=[1, 0]

zoom=1, tile=[1, 1]

zoom=2, tile=[0, 0]

…

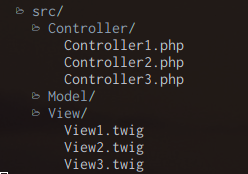

Поскольку запросы известны заранее, ответы на запросы тоже можно сгенерировать заранее. Организуем на сервере какую-то такую файловую структуру.

В файлах будет храниться примерно такой код:

```

myCallback_x_1_y_2_z_5({

"type": "FeatureCollection",

"features": [

{

"type": "Feature",

"id": 0,

"geometry": {

"type": "Point",

"coordinates": [55.831903, 37.411961]

},

"properties": {

"balloonContent": "Содержимое балуна",

"clusterCaption": "Метка 1",

"hintContent": "Текст подсказки"

}

},

...

]

}

```

При загрузке такого файла на клиенте будет вызван JSONP-callback, прописанный в файле. Данные попадут в недры LoadingObjectManager, закешируются и отрисуются в нужном виде.

В результате на сервере можно хранить просто статические файлы с наборами данных, а клиентская часть сама решит, что ей когда запросить и показать.

#### 2. Динамическое формирование ответа из статических файлов

Существенным минусом вышеописанного решения является большое количество запросов за данными от клиента к серверу. Намного целесообразнее отправлять запрос сразу за несколькими тайлами, чем запрашивать данные для каждого тайла по отдельности.Но для обработки запросов за группами тайлов уже придется написать некоторый серверный код.

При этом данные можно продолжить хранить в отдельных файлах. Когда от клиента поступит запрос за данными в некоторой прямоугольной области, достаточно будет склеить содержимое нескольких файлов в один ответ и отправить его обратно на клиент.

#### 3. Динамическое формирование ответа с использованием базы данных

Самый верный, на наш взгляд, путь – реализовать серверную часть с использованием какой-либо базы данных, умеющей индексировать геопривязанные данные. Для любой базы, не поддерживающей пространственные индексы, можно создать подобный индекс самостоятельно, используя [концепцию пространственных ключей](https://karussell.wordpress.com/2012/05/23/spatial-keys-memory-efficient-geohashes/).

Вообще хранение геопривязанных данных на сервере и их кластеризация – тема отдельной беседы. Так что обсудим в другой раз.

[В этом репозитории](https://github.com/dimik/geohosting-server) живет пример реализации серверной части с серверной grid-кластеризацией, написанный на node.js + mongo.db. может кому-то пригодится ([Демо](http://dimik.github.io/ymaps/examples/2.1/remote-object-manager/)).

### Заключение

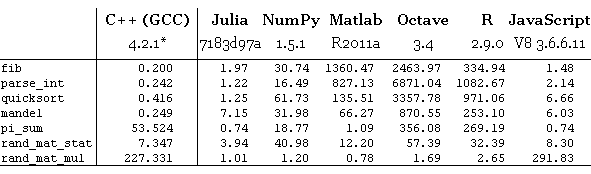

Сравнительная таблица новых модулей.

| Модуль | Преимущества | Недостатки |

| --- | --- | --- |

| ObjectManager | Позволяет кластеризовать объекты на клиенте.

Отрисовка производится только тех объектов, которые попадают в видимую область карты.

Позволяет фильтровать объекты при их отображении.

Нет необходимости реализовывать серверную часть, поскольку вся обработка данных производится на стороне клиента. | Поддерживает работу только с метками.

Данные загружаются для всех объектов сразу (даже для тех, которые не попадают в видимую область карты).

Кластеризация объектов производится на стороне клиента. |

| LoadingObjectManager | Позволяет кластеризовать объекты на клиенте.

Загружает данные только для видимой области карты.

Сохраняет загруженные данные. Для каждого объекта данные загружаются только один раз.

Позволяет фильтровать объекты при их отображении. | Поддерживает работу только с метками.

Кластеризация объектов производится на стороне клиента.

Необходимо реализовать серверную часть. |

| RemoteObjectManager | Использует серверную кластеризацию данных.

Данные объектов хранятся на сервере. Каждый раз подгружаются данные только для тех объектов, которые попадают в видимую область карты. | Поддерживает работу только с метками.

При изменении коэффициента масштабирования данные загружаются заново (даже для тех объектов, для которых данные уже были загружены).

Необходимо реализовывать собственную кластеризацию.

Необходимо реализовать серверную часть. |

На данный момент мы поддерживаем работу только с точечными объектами. Поддержка полигонов, полилиний и прочих прекрасных фигур стоит у нас в планах и появится в будущих релизах.

Когда стоит задуматься об использовании этих модулей? Почти в любой ситуации, когда вам надо отрисовать на карте много точечных объектов.

Полезные ссылки:

1. Подробнейшее руководство разработчика с картинками – [tech.yandex.ru/maps/doc/jsapi/2.1/dg/concepts/many-objects-docpage](https://tech.yandex.ru/maps/doc/jsapi/2.1/dg/concepts/many-objects-docpage/).

2. Примеры в песочнице – [tech.yandex.ru/maps/jsbox/2.1/object\_manager](https://tech.yandex.ru/maps/jsbox/2.1/object_manager)

3. Проект на гитхабе с примером реализации серверной части для RemoteObjectManager – [github.com/dimik/geohosting-server](https://github.com/dimik/geohosting-server).

4. Клуб разработчиков API Яндекс.Карт, куда нужно приходить с вопросами – [clubs.ya.ru/mapsapi](http://clubs.ya.ru/mapsapi). | https://habr.com/ru/post/243665/ | null | ru | null |

# Перехват изменения значения атрибута у DOM элемента средствами Javascript

Пытаю решить задачу:

**Вызвать событие при изменении атрибута disabled у Input'a.**

Хотя на самом деле интерес в перехвате изменения любого атрибута,

а в случае с `disabled="disabled"` — перехват создания и уничтожения этого атрибута.

Решать такую задачу setInterval не рационально. Если таких элементов будет 100,

то тормоза неизбежны. Может кто-то уже справился с этой проблемой?

**UPD: [Одно из возможных решений](http://webpeppers.ru/33.html)** | https://habr.com/ru/post/80397/ | null | ru | null |

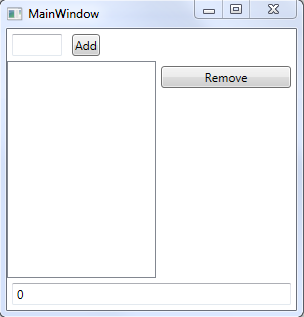

# MVVM: полное понимание (+WPF) Часть 1

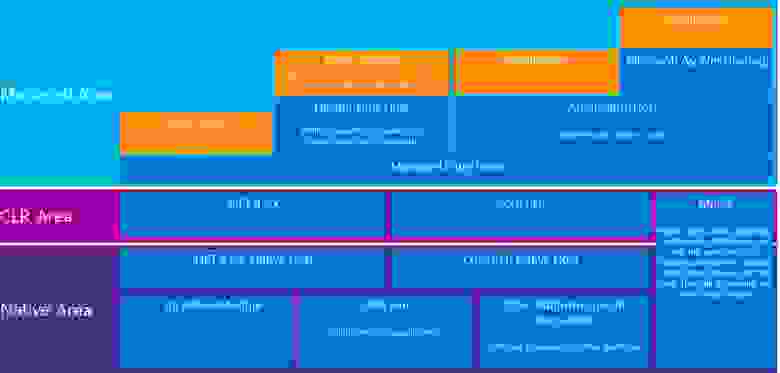

В настоящей статье задействован мой опыт доведения некоторого числа студентов до полного и окончательного понимания паттерна **MVVM** и реализации его в **WPF**. Паттерн описывается на примерах возрастающей сложности. Сначала теоретическая часть, которая может использоваться безотносительно конкретного языка, затем практическая часть, в которой показано несколько вариантов реализации коммуникации между слоями с использованием WPF и, немножко, Prism.

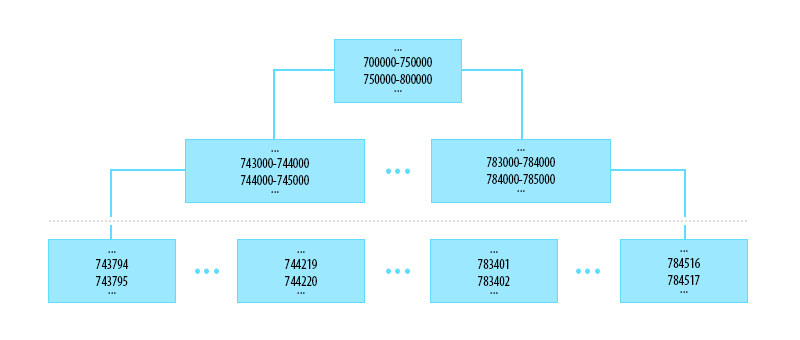

**Зачем вообще нужно использовать паттерн MVVM? Это ведь лишний код! Написать тоже самое можно гораздо понятнее и прямолинейнее.**

Отвечаю: в маленьких проектах прямолинейный подход срабатывает. Но стоит ему стать чуть больше — и логика программы размазывается в интерфейсе так, что потом весь проект превращается в монолитный клубок, который проще переписать заново, чем пытаться распутать. Для наглядности можно посмотреть на две картинки:

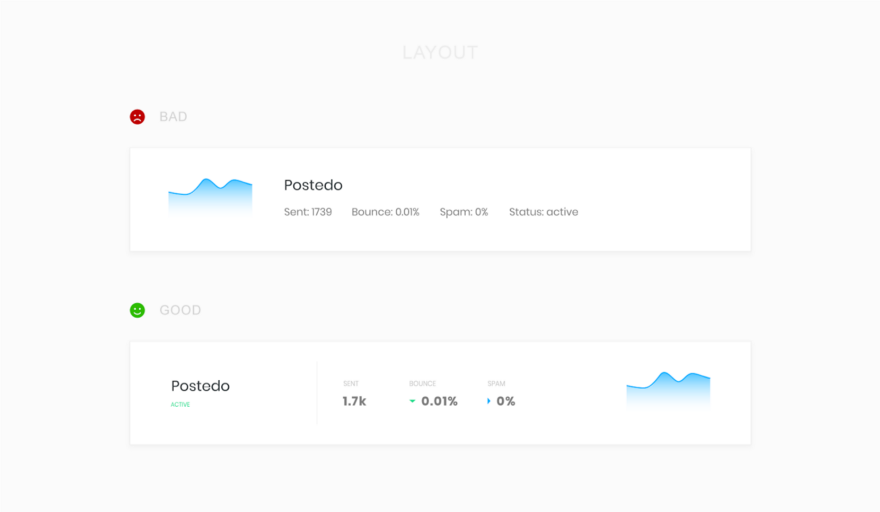

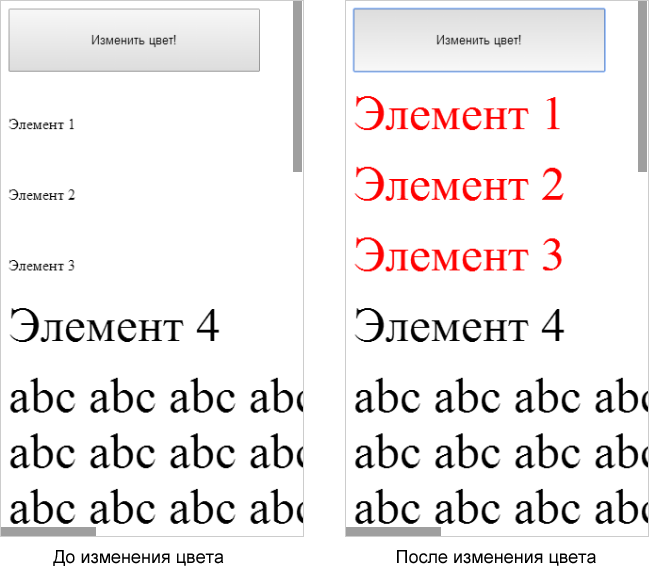

*Изображение 1: код без MVVM.*

*Изображение 2: код с MVVM.*

В первом случае программист, со словами «Мне нужно просто соединить вот этот порт и этот, зачем мне все эти хомутики и лейблики?», просто соединяет патчкордом пару слотов. Во втором случае использует некоторый шаблонный подход.

Рассмотрение паттерна на примере №1: Сложение двух чисел с выводом результата

-----------------------------------------------------------------------------

Методика:

Методика написания программы используя подход «ModelFirst».

* 1. Разработать модель программы.

* 2. Нарисовать интерфейс программы.

* 3. Соединить интерфейс и модель прослойкой VM.

Итак, наше задание — написать программу сложения двух чисел с выводом результата. Выполняем первый пункт: пишем модель. Модель — это место в программе, которое может требовать некоторое творческое усилие или задействие своих творческих способностей.

Однако творчество — это довольно затратный по ресурсам мыслительный процесс, и следует избегать излишнее обращение к нему. Во-первых — чтобы не перенапрягаться. Во-вторых — чтобы ваш собрат по программированию (да и вы сами, через пару недель) заглянув к вам в код, не был бы принужден к, излишне увлекательному порой, следованию за творческим полетом мысли. Все места, где вам вдруг удалось применить творчество, — необходимо снабдить подробным комментарием. Кстати, существуют многочисленные паттерны программирования, которые помогают вам это самое творчество — не применять.

Итак, моделью в нашей задаче будет сложение чисел с возвратом результата. Модель, в принципе, может не хранить никакого состояния. Т.е. она может вполне быть реализована статическим методом статического класса. Примерно так:

```

static class MathFuncs {

public static int GetSumOf(int a, int b) => a + b;

}

```

Следующий шаг — (см. методику «ModelFirst») — создать View или, проще — нарисовать интерфейс. Это тоже часть, которая может содержать творчество. Но, опять же, не стоить с ним перебарщивать. Пользователь не должен быть шокирован неожиданностями интерфейса. Интерфейс должен быть интуитивен. Наша View будет содержать три текстовых поля, которые можно снабдить лейблами: число номер один, число номер два, сумма.

Заключительный шаг — соединение View и модели через VM. VM — это такое место, которое вообще не должно содержать творческого элемента. Т.е. эта часть паттерна железно обуславливается View и не должна содержать в себе НИКАКОЙ «бизнес логики». Что значит обусловленность от View? Это значит, что если у нас во View есть три текстовых поля, или три места, которые должны вводить/выводить данные — следовательно в VM (своего рода подложке) должны быть минимум три свойства, которые эти данные принимают/предоставляют.

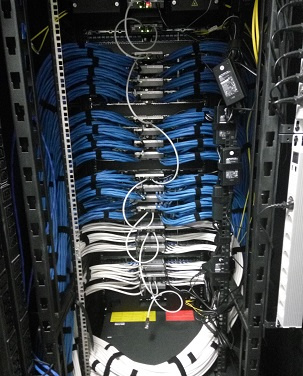

Следовательно два свойства принимают из View число номер один и два, а третье свойство — вызывает нашу модель для выполнения бизнес-логики нашей программы. VM ни в коем случае не выполняет сложение чисел самостоятельно, оно для этого действия только вызывает модель! В этом и состоит функция VM — соединять View (которое тоже ничем иным, кроме как приема ввода от пользователя и предоставления ему вывода не занимается) и Модель, в которой происходит все вычисление. Если нарисовать картинку нашей задачки, то получиться нечто такое:

*Изображение 3: Схема Примера №1*

Зеленое — это View, три зеленые точки в которой — это наши три текстовые поля. Синее — это VM, к которой эти три зеленых точки железно прибиты (прибиндены), ну а красное облачко — это модель, которая занимается вычислением.

Реализация Примера №1 в WPF

---------------------------

Конкретно в WPF реализована «аппаратная поддержка» паттерна MVVM. View реализуется в XAML. Т.е. зеленый слой (View) будет написана на XAML. Зеленые точки — это будут текстовые поля. А зеленые линии, соединяющиеся с синими — будут реализованы через механизм Binding. Зеленая пунктирная линия — связь всей View и VM осуществляется, когда мы создаем объект VM и присваиванием его свойству DataContext View.

Рисуем View:

```

```

Теперь выполняем последний пункт методики — реализуем VM. Чтобы наша VM «автоматически» обновляла View, требуется реализовать интерфейс INotifyPropertyChange. Именно посредством него View получает уведомления, что во VM что-то изменилось и требуется обновить данные.

Делается это следующим образом:

```

public class MainVM : INotifyPropertyChange

{

public event PropertyChangedEventHandler PropertyChanged;

protected virtual void OnPropertyChanged(string propertyName) {

PropertyChanged?.Invoke(this, new PropertyChangedEventArgs(propertyName));

}

}

```

Теперь снабдим VM тремя необходимыми свойствами. (Требования для установления связи VM и View такое, что это должны быть открытые свойства)

```

private int _number1;

public int Number1 { get {return _number1;}

set { _number1 = value;

OnPropertyChanged("Number3"); // уведомление View о том, что изменилась сумма

}

}

private int _number2;

public int Number2 { get {return _number2;}

set { _number1 = value; OnPropertyChanged("Number3"); } }

```

Последнее свойство — это линия пунктирная синяя линия связи VM и модели:

```

//свойство только для чтения, оно считывается View каждый раз, когда обновляется Number1 или Number2

public int Number3 { get; } => MathFuncs.GetSumOf(Number1, Number2);

```

Мы реализовали полноценное приложение с применением паттерна MVVM.

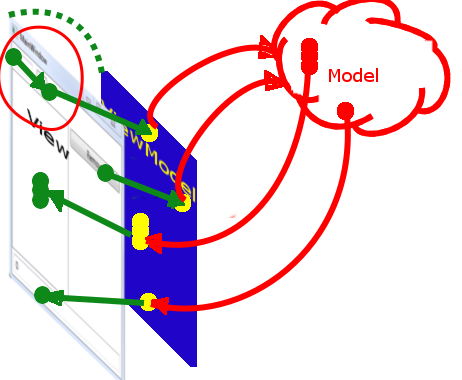

**Рассмотрение паттерна на примере №2:**

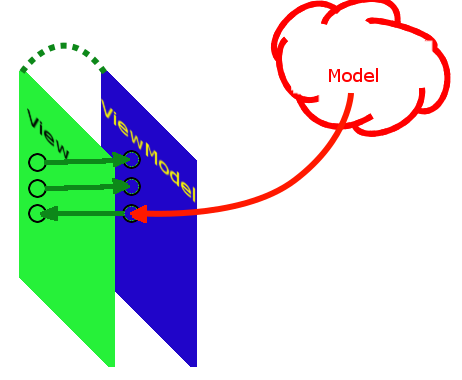

Теперь усложним наше задание. В программе будет текстовое поле для ввода числа. Будет ListBox с коллекцией значений. Кнопка «Добавить», по нажатию на которую число в текстовом поле будет добавлено в коллекцию значений. Кнопка удалить, по нажатию на которую выделенное в ListBox'е число будет удалено из коллекции. И текстовое поле с суммой всех значений в коллекции.

*Изображение 4: Интерфейс для Примера №2*

Согласно методике — необходимо сначала разработать модель. Теперь модель не может быть stateless и должна хранить состояние. Значит в модели будет коллекция элементов. Это раз. Затем — операция добавление некоторого числа в коллекцию — это обязанность модели. VM не может залезать во внутренность модели и самостоятельно добавлять в коллекцию модели число, она обязана просить сделать это саму модель. В противном случае это будет нарушение принципа инкапсуляции. Это как если бы водитель не заливал, как положено, топливо в бензобак и т.д. — а лез бы под капот и впрыскивал топливо непосредственно в цилиндр. То есть будет метод «добавить число в коллекцию». Это два. И третье: модель будет предоставлять сумму значений коллекции и точно также уведомлять об ее изменении через интерфейс **INotifyPropertyChanged**. Не будем разводить споры о чистоте модели, а будем просто использовать уведомления.

Давайте сразу реализуем модель:

Коллекция элементов должна уведомлять подписчиков о своем изменении. И она должна быть только для чтения, чтобы никто, кроме модели, не могли ее как-либо изменить. Ограничение доступа — это выполнение принципа инкапсуляции, оно должно соблюдаться неукоснительно, чтобы: а) самому случайно не создать ситуацию трудноуловимого дебага, б) вселить уверенность, что поле не изменяется извне — опять же, в целях облегчения отладки.

Кроме того, так так мы далее все равно подключим Prism для **DelegateCommand**, то давайте сразу использовать BindableBase вместо самостоятельной реализации INotifyPropertyChange. Для этого надо подключить через NuGet библиотек Prism.Wpf (на момент написания 6.3.0). Соответственно OnPropertyChanged() измениться на RaisePropertyChanged().

```

public class MyMathModel : BindableBase

{

private readonly ObservableCollection \_myValues = new ObservableCollection();

public readonly ReadOnlyObservableCollection MyPublicValues;

public MyMathModel() {

MyPublicValues = new ReadOnlyObservableCollection(\_myValues);

}

//добавление в коллекцию числа и уведомление об изменении суммы

public void AddValue(int value) {

\_myValues.Add(value);

RaisePropertyChanged("Sum");

}

//проверка на валидность, удаление из коллекции и уведомление об изменении суммы

public void RemoveValue(int index) {

//проверка на валидность удаления из коллекции - обязанность модели

if (index >= 0 && index < \_myValues.Count) \_myValues.RemoveAt(index);

RaisePropertyChanged("Sum");

}

public int Sum => MyPublicValues.Sum(); //сумма

}

```

Согласно методике — рисуем View. Перед этим несколько необходимых пояснений. Для того, чтобы создать связь кнопки и VM, необходимо использовать DelegateCommand. Использование для этого событий и кода формы, для чистого MVVM — непозволительно. Используемые события необходимо обрамлять в команды. Но в случае с кнопкой такого обрамления не требуется, т.к. существует специальное ее свойство Command.

Кроме того, число, которое мы будем добавлять, используя DelegateCommand, мы будем не биндить к VM, а будем передавать в качестве параметра этого DelegateCommand, чтобы не загромождать VM и избежать рассинхронизации непосредственного вызова команды и использования параметра. Обратите внимание на получившуюся схему и, особенно, на место, обведенное красной линией.

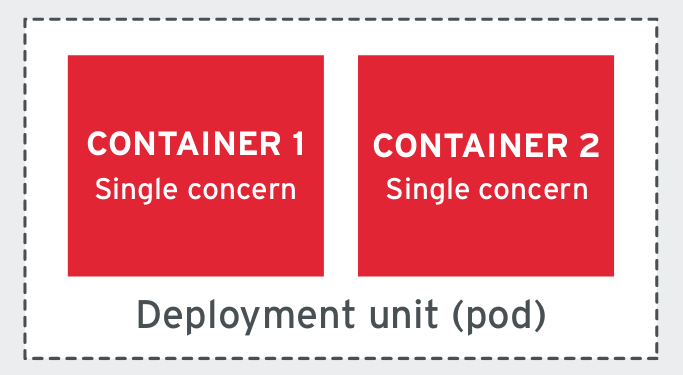

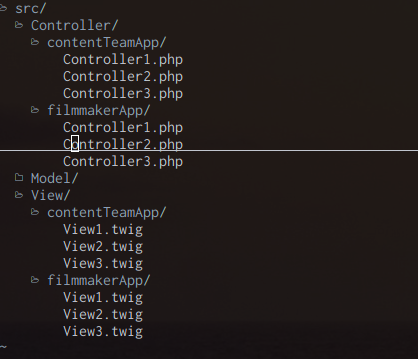

*Изображение 5: Схема для Примера №2*

Здесь привязка на View происходит не вида View <=> ViewModel, а вида View <=> View. Для того, чтобы этого добиться используется второй вид биндинга, где указывается имя элемента и его свойства, к которому осуществляться привязка — "{Binding ElementName=TheNumber, Path=Text}".

```

```

Теперь реализуем ViewModel:

```

public class MainVM : BindableBase

{

readonly MyMathModel _model = new MyMathModel();

public MainVM()

{

//таким нехитрым способом мы пробрасываем изменившиеся свойства модели во View

_model.PropertyChanged += (s, e) => { RaisePropertyChanged(e.PropertyName); };

AddCommand = new DelegateCommand(str => {

//проверка на валидность ввода - обязанность VM

int ival;

if (int.TryParse(str, out ival)) \_model.AddValue(ival);

});

RemoveCommand = new DelegateCommand(i => {

if(i.HasValue) \_model.RemoveValue(i.Value);

});

}

public DelegateCommand AddCommand { get; }

public DelegateCommand RemoveCommand { get; }

public int Sum => \_model.Sum;

public ReadOnlyObservableCollection MyValues => \_model.MyPublicValues;

}

```

**Внимание — важно!** Касательно проброса уведомлений из модели. Уведомлять об изменении суммы самостоятельно VM не может, т.к. она не должна знать, что именно измениться в модели, после вызова ее методов и измениться ли вообще. Модель для VM должна быть черным ящиком. Т.е. она должна передавать ввод и действия пользователя в модель и если в модели что-то изменилось (о чем должна ее уведомлять сама модель), то только тогда уведомлять далее View.

Мы реализовали второе полноценное приложение с применением паттерна MVVM, познакомились с ObservableCollection, DelegateCommand, привязкой вида View <=> View и пробросом уведомлений во View. | https://habr.com/ru/post/338518/ | null | ru | null |

# Julia: типы, мультиметоды и арифметика над полиномами

В этой публикации речь пойдёт об основной, на мой взгляд, отличительной особенности языка Julia — представлении функций в виде методов с множественной диспетчеризацией. Это позволяет повысить производительность вычислений, не снижая читаемости кода и не портя абстрагируемость, с одной стороны, и позволяет работать с математическими понятиями в более привычной нотации, с другой. Для примера рассмотрен вопрос единообразной (с точки зрения линейных операций) работы с полиномами в представлении списка коэффициентов и с интерполяционными полиномами.

Базовый синтаксис

-----------------

Краткое введение для тех, кто не в курсе. Julia — как-бы-скриптовый язык, имеет REPL (read-evaluate-print loop, т.е. интерактивную оболочку). С первого взгляда выглядит довольно похоже на, например, Python или MATLAB.

#### Арифметические операции

Арифметика примерно такая же, как и везде: +, -, \*, /, ^ для возведения в степень и т.д.

Сравнение: >, <, >=, <=, ==, != и т.д.

Присваивание: =.

Особенности: деление через `/` всегда возвращает дробное число; если нужна целая часть от деления двух целых чисел, нужно пользоваться операцией `div(m, n)` или инфиксным эквивалентом `m ÷ n`.

#### Типы

Числовые типы:

* Целые (`Int`) — `2`, `3`, `-42`

* Беззнаковые целые (`UInt`) — `0x12345`

* С плавающей точкой (`Float32`, `Float64`) — `1.0`, `3.1415`, `-Inf`, `NaN`

* Рациональные (`Rational`) — `3//3`, `7//2`

* Действительные (`Real`) — всё вышеперечисленное

* Комплексные (`Complex`) — `3+4*im`, `2//3+2//3*im`, `3.0+0.0*im` (`im` — мнимая единица, комплексным считается только число с явно выписанной мнимой частью)

* Число (`Number`) — всё вышеперечисленное

Строки и символы:

* `'a'` — символ (`Char`)

* `"a"` — строка (`String`)

NB: строки, как сейчас во многих языках, иммутабельные.

NB: строки (а также имена переменных) поддерживают Юникод, в том числе и эмодзи.

Массивы:

* `x = [1, 2, 3]` — задание массива прямым перечислением элементов

* специальные конструкторы: `zeros(length)` для массива из нулей, `ones(length)` для массива из единиц, `rand(length)` для массива из случайных чисел и др.

* поддержка многомерных массивов

* поддержка операций линейной алгебры (сложение массивов, умножение на скаляр, умножение матрицы на вектор и многое другое) в стандартной библиотеке

NB: индексация всех коллекций идёт начиная с единицы.

NB: т.к. язык предназначен для вычислительных задач, массивы — один из наиболее важных типов, к принципам их работы ещё не раз придётся возвращаться.

Кортежи (упорядоченный набор элементов, иммутабельные):

* `(2, 5.3, "k")` — обычный кортеж

* `(a = 3, b = 4)` — именованный кортеж

NB: к полям именованного кортежа можно обращаться как по имени через точку, так и по индексу через []

```

julia> x = (a = 5, b = 12)

(a = 5, b = 12)

julia> x[1]

5

julia> sqrt(x.a^2 + x[2]^2)

13.0

```

Словари:

```

julia> x = Dict('a' => 5, 'b' => 12)

Dict{Char,Int64} with 2 entries:

'a' => 5

'b' => 12

julia> x['c'] = 13

13

julia> x

Dict{Char,Int64} with 3 entries:

'a' => 5

'c' => 13

'b' => 12

```

#### Основные управляющие конструкции языка

1. Переменные автоматически создаются при присваивании. Тип указывать необязательно.

```

julia> x = 7; x + 2

9

julia> x = 42.0; x * 4

168.0

```

2. Блок условного перехода начинается с выражения `if` и заканчивается словом `end`. Можно также иметь `else`-ветку или `elseif`-ветки:

```

if x > y

println("X is more than Y")

elseif x == y

println("X and Y are equal")

else

println("X is less than Y")

end

```

3. Есть две конструкции циклов: `while` и `for`. Второй работает как в Python, т.е. проводит итерирование по коллекции. Частое применение — итерирование по диапазону значений, синтаксис которого `start[:increment]:end`. В отличие от Python, диапазон *включает* как начальное, так и конечное значения, т.е. пустой диапазон будет не `1:1` (это диапазон из одного значения 1), а `1:0`. Конец тела цикла маркируется словом `end`.

```

julia> for i in 1:3; print(i, " "); end # диапазон от 1 до 3 с шагом 1 (по умолчанию)

1 2 3

julia> for i in 1:2:3; print(i, " "); end # диапазон от 1 до 3 с шагом 2

1 3

```

4. Функции задаются ключевым словом `function`, определение функции также завершается словом `end`. Поддерживаются аргументы со значениями по умолчанию и именованные аргументы.

```

function square(x)

return x * x

end

function cube(x)

x * square(x) # последнее вычисленное значение возвращается из блока кода; return не обязателен

end

function root(x, degree = 2)

# аргумент degree имеет значение по умолчанию

return x^(1.0/degree)

end

function greeting(name; times = 42, greet = "hello")

# именованные аргументы отделяются точкой с запятой

println(times, " times ", greet, " to ", name)

end

julia> greeting("John")

42 times hello to John

julia> greeting("Mike", greet = "wassup", times = 100500) # именованные аргументы при вызове функции могут стоять в любом порядке

100500 times wassup to Mike

```

В целом, это всё довольно похоже на Python, если не считать мелких отличий в синтаксисе и того, что блоки кода выделяются не пробелами, а всё-таки ключевыми словами. В простых случаях программы на Python даже транслируются в Julia практически один к одному.

Но есть существенное отличие в том, что в Julia для переменных можно явно указывать типы, что позволяет компилировать программы, получая быстрый код.

Второе существенное отличие — в том, что в Python реализована «классическая» модель ООП с классами и методами, а в Julia реализована модель множественной диспетчеризации.

#### Аннотации типов и множественная диспетчеризация

Посмотрим, что представляет собой какая-нибудь встроенная функция:

```

julia> sqrt

sqrt (generic function with 19 methods)

```

Как показывает нам REPL, `sqrt` — это обобщённая функция с 19 методами. Что за обобщённая функция и что за методы?

А означает это то, что есть *несколько* функций `sqrt`, которые применяются к разным типам аргументов и, соответственно, вычисляют квадратный корень по различным алгоритмам. Посмотреть, какие есть варианты, можно, набрав

```

julia> methods(sqrt)

```

Видно, что функция определена для разных типов чисел, а также для матриц.

В отличие от «классического» ООП, где конкретная реализация метода определяется только вызывающим классом (диспетчеризация по первому аргументу), в Julia выбор функции определяется типами (и количеством) *всех* её аргументов.

При вызове функции с конкретными аргументами из всех её методов выбирается тот, который наиболее точно описывает конкретный набор типов, с которыми функция вызвана, и именно он применяется.

Отличительной особенностью является то, что применяется подход, называемый авторами языка «just ahead-of-time» компиляцией. Т.е. функции компилируются для заданных типов данных при первом вызове, после чего следующие вызовы выполняются гораздо быстрее. Разница между первым и последующими вызовами может быть весьма существенной:

```

julia> @time sqrt(8) # макрос @time - простое встроенное средство измерения производительности

0.006811 seconds (3.15 k allocations: 168.516 KiB) # на самом деле, это время и выделение памяти при компиляции

2.8284271247461903

julia> @time sqrt(15)

0.000002 seconds (5 allocations: 176 bytes) # 5 выделений памяти - это от вызова макроса @time

3.872983346207417

```

В плохом случае каждый вызов функции — это проверка типов получаемых аргументов и поиск нужного метода в списке. Однако, если компилятору давать подсказки, проверки можно исключить, что приведёт к более быстрому коду.

Для примера, рассмотрим вычисление суммы

```

function mysqrt(num)

# если аргумент положителен - возвращает обычный квадратный корень

# если нет - преобразует аргумент к комплексному числу и извлекает корень из него

if num >= 0

return sqrt(num)

else

return sqrt(complex(num))

end

end

function S(n)

# оставим автоопределение типа

sum = 0

sgn = -1

for k = 1:n

sum += mysqrt(sgn)

sgn = -sgn

end

return sum

end

function S_typed(n::Integer)

# т.к. уже первое слагаемое получается комплексное, то ответ должен быть комплексным

# тип переменных указывается через

sum::Complex = 0.0

sgn::Int = -1

for k = 1:n

sum += mysqrt(sgn)

sgn = -sgn

end

return sum

end

```

Бенчмарк показывает, что функция `S_typed()` не только выполняется быстрее, но ещё и не требует выделений памяти при каждом вызове, в отличие от `S()`. Проблема тут в том, что тип возвращаемого из `mysqrt()` значения не определён, как и тип правой части выражения

```

sum = sum + mysqrt(sgn)

```

Как следствие, компилятор даже не может понять, какого типа будет `sum` на каждой итерации. А значит, боксинг (прицепление метки типа) переменной и выделение памяти.

Для функции `S_typed()` компилятор заранее знает, что `sum` — это комплексное значение, поэтому код получается более оптимизированным (в частности, вызов `mysqrt()` можно эффективно заинлайнить, приводя возвращаемое значение всегда к `Complex`).

Что ещё важнее, для `S_typed()` компилятор знает, что возвращаемое значение имеет тип `Complex`, а вот для `S()` тип выходного значения опять не определён, что будет замедлять и все функции, где `S()` будет вызываться.

Проверить, что компилятор думает о типах, возвращаемых из выражения, можно с помощью макроса `@code_warntype`:

```

julia> @code_warntype S(3)

Body::Any # компилятор не знает до вычисления, какого типа будет возвращаемое значение

...

julia> @code_warntype S_typed(3)

Body::Complex{Float64} # компилятор сразу знает возвращаемый тип

...

```

Если у вас где-то в цикле вызывается функция, для которой `@code_warntype` не может вывести возвращаемый тип, или для которой он в теле где-то показывает получение значения типа `Any` — то оптимизация этих вызовов с большой вероятностью даст очень ощутимый прирост производительности.

#### Составные типы

Программист может определить составные типы данных для своих нужд с помощью конструкции `struct`:

```

julia> struct GenericStruct

# внутри блока struct идёт перечисление полей

name

b::Int

c::Char

v::Vector

end

# конструктор по умолчанию принимает позиционные аргументы

# и присваивает их полям в том порядке, в котором они идут в объявлении типа

julia> s = GenericStruct("Name", 1, 'z', [3., 0])

GenericStruct("Name", 1, 'z', [3.0, 0.0])

julia> s.name, s.b, s.c, s.v

("Name", 1, 'z', [3.0, 0.0])

```

Структуры в Julia иммутабельны, т.е., создав экземпляр структуры, поменять значения полей уже нельзя (точнее, нельзя поменять адрес полей в памяти — элементы мутабельных полей, как, например, `s.v` в примере выше, могут быть изменены). Мутабельные структуры создаются конструкцией `mutable struct`, синтаксис которой такой же, как и для обычных структур.

Наследование структур в «классическом» смысле не поддерживается, однако есть возможность «наследования» поведения путём объединения составных типов в надтипы или, как они называются в Julia, абстрактные типы. Отношения типов выражаются как `A<:B` (A — подтип B) и `A>:B` (A — надтип B). Выглядит примерно так:

```

abstract type NDimPoint end # абстрактный тип - нужен только как интерфейс

# считаем, что производные типы - это просто кортежи из N чисел

struct PointScalar<:NDimPoint

x1::Real

end

struct Point2D<:NDimPoint

x1::Real

x2::Real

end

struct Point3D<:NDimPoint

x1::Real

x2::Real

x3::Real

end

# документация пишется перед определением функции; поддерживается форматирование Markdown

"""

mag(p::NDimPoint)

Calculate the magnitude of the radius vector of an N-dimensional point `p`

"""

function mag(p::NDimPoint)

sqrmag = 0.0

# т.к. размерность точно неизвестна, нужно итерировать по всем полям структуры

# имена полей для типа T получаются вызовом fieldnames(T)

for name in fieldnames(typeof(p))

sqrmag += getfield(p, name)^2

end

return sqrt(sqrmag)

end

"""

add(p1::T, p2::T) where T<:NDimPoint

Calculate the sum of the radius vectors of two N-dimensional points `p1` and `p2`

"""

function add(p1::T, p2::T) where T<:NDimPoint

# сложение - уже сложнее, т.к. оба аргумента должны быть одинаковых типов

# для получения компонентов используется list comprehension

sumvector = [Float64(getfield(p1, name) + getfield(p1, name)) for name in fieldnames(T)]

# возвращаем точку того же типа, что и аргументы

# оператор ... разбивает коллекцию на отдельные аргументы функции, т.е.

# f([1, 2, 3]...) - это то же, что f(1, 2, 3)

return T(sumvector...)

end

```

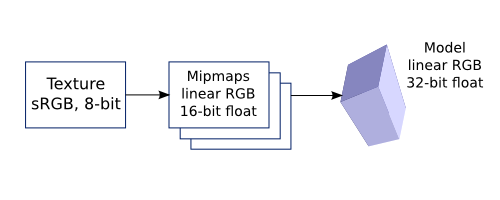

#### Case study: Полиномы

Система типов вкупе с множественной диспетчеризацией удобна для выражения математических понятий. Рассмотрим на примере простой библиотеки для работы с полиномами.

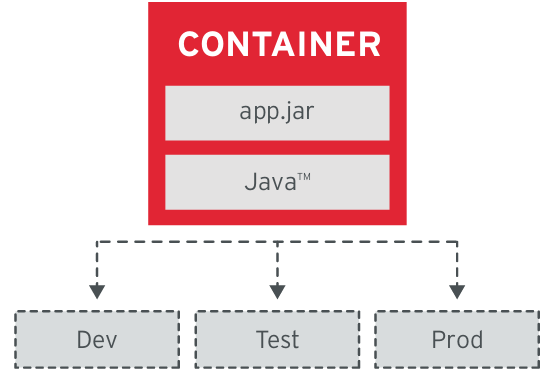

Введём два типа полиномов: «канонический», задаваемый через коэффициентами при степенях, и «интерполяционный», задаваемый набором пар (x, f(x)). Для простоты рассматривать будем только действительные аргументы.

Для хранения многочлена в обычной записи подходит структура, имеющая в качестве поля массив или кортеж коэффициентов. Чтобы было совсем иммутабельно, пусть будет кортеж. Таким образом, код для задания абстрактного типа, структуры многочлена и вычисления значения многочлена в заданной точке довольно простой:

```

abstract type AbstractPolynomial end

"""

Polynomial <: AbstractPolynomial

Polynomials written in the canonical form

"""

struct Polynomial<:AbstractPolynomial

degree::Int

coeff::NTuple{N, Float64} where N # NTuple{N, Type} - тип кортежа из N элементов одинакового типа

end

"""

evpoly(p::Polynomial, z::Real)

Evaluate polynomial `p` at `z` using the Horner's rule

"""

function evpoly(p::Polynomial, z::Real)

ans = p.coeff[end]

for idx = p.degree:-1:1

ans = p.coeff[idx] + z * ans

end

return ans

end

```

Для интерполяционных полиномов нужна другая структура представления и способ вычисления. В частности, если набор точек интерполяции известен заранее, и один и тот же многочлен планируется вычислять в разных точках, удобна [интерполяционная формула Ньютона](https://en.wikipedia.org/wiki/Newton_polynomial):

где *nk*(*x*) — базисные полиномы, *n0*(*x*) и для *k*>0

где *xi* — узлы интерполяции.

Из приведённых формул видно, что хранение удобно организовать в виде набора узлов интерполяции *xi* и коэффициентов *ci*, а вычисление может быть сделано способом, аналогичным схеме Горнера.

```

"""

InterpPolynomial <: AbstractPolynomial

Interpolation polynomials in Newton's form

"""

struct InterpPolynomial<:AbstractPolynomial

degree::Int

xval::NTuple{N, Float64} where N

coeff::NTuple{N, Float64} where N

end

"""

evpoly(p::Polynomial, z::Real)

Evaluate polynomial `p` at `z` using the Horner's rule

"""

function evpoly(p::InterpPolynomial, z::Real)

ans = p.coeff[p.degree+1]

for idx = p.degree:-1:1

ans = ans * (z - p.xval[idx]) + p.coeff[idx]

end

return ans

end

```

Функция для вычисления значения полинома в обоих случаях называется одинаково — `evpoly()` — но принимает разные типы аргументов.

Кроме функции вычисления, неплохо бы ещё написать функцию, создающую полином по известным данным.

Для этого в Julia есть две методики: внешние конструкторы и внутренние конструкторы. Внешний конструктор — это просто функция, возвращающая объект соответствующего типа. Внутренний конструктор — это функция, которая вводится внутри описания структуры и заменяет собой стандартный конструктор. Для построения интерполяционных полиномов целесообразно использовать именно внутренний конструктор, поскольку

* получить полином удобнее не через узлы интерполяции и коэффициенты, а через узлы и значения интерполируемой функции

* узлы интерполяции должны обязательно быть различными

* число узлов и коэффициентов должно совпадать

Написание внутреннего конструктора, в котором гарантированно будут соблюдаться эти правила, гарантирует, что все создаваемые переменные типа `InterpPolynomial`, по крайней мере, могут корректно быть обработаны функцией `evpoly()`.

Напишем конструктор обычных полиномов, принимающий на вход одномерный массив или кортеж коэффициентов. Конструктор интерполяционного полинома принимает на вход узлы интерполяции и желаемые значения в них и использует [метод разделенных разностей](https://en.wikipedia.org/wiki/Newton_polynomial#Examples) для вычисления коэффициентов.

```

"""

Polynomial <: AbstractPolynomial

Polynomials written in the canonical form

---

Polynomial(v::T) where T<:Union{Vector{<:Real}, NTuple{<:Any, <:Real}})

Construct a `Polynomial` from the list of the coefficients. The coefficients are assumed to go from power 0 in the ascending order. If an empty collection is provided, the constructor returns a zero polynomial.

"""

struct Polynomial<:AbstractPolynomial

degree::Int

coeff::NTuple{N, Float64} where N

function Polynomial(v::T where T<:Union{Vector{<:Real},

NTuple{<:Any, <:Real}})

# в случае пустого массива / кортежа в аргументе возвращаем P(x) ≡ 0

coeff = isempty(v) ? (0.0,) : tuple([Float64(x) for x in v]...)

# возврат значения - специальным оператором new

# аргументы - перечисление значений полей

return new(length(coeff)-1, coeff)

end

end

"""

InterpPolynomial <: AbstractPolynomial

Interpolation polynomials in Newton's form

---

InterpPolynomial(xsample::Vector{<:Real}, fsample::Vector{<:Real})

Construct an `InterpPolynomial` from a vector of points `xsample` and corresponding function values `fsample`. All values in `xsample` must be distinct.

"""

struct InterpPolynomial<:AbstractPolynomial

degree::Int

xval::NTuple{N, Float64} where N

coeff::NTuple{N, Float64} where N

function InterpPolynomial(xsample::X,

fsample::F) where {X<:Union{Vector{<:Real},

NTuple{<:Any, <:Real}},

F<:Union{Vector{<:Real},

NTuple{<:Any, <:Real}}}

# проверки на то, что все узлы различны, и значений f столько же, сколько узлов

if !allunique(xsample)

throw(DomainError("Cannot interpolate with duplicate X points"))

end

N = length(xsample)

if length(fsample) != N

throw(DomainError("Lengths of X and F are not the same"))

end

coeff = [Float64(f) for f in fsample]

# алгоритм расчета разделенных разностей (Stoer, Bulirsch, Introduction to Numerical Analysis, гл. 2.1.3)

for i = 2:N

for j = 1:(i-1)

coeff[i] = (coeff[j] - coeff[i]) / (xsample[j] - xsample[i])

end

end

new(N-1, tuple([Float64(x) for x in xsample]...), tuple(coeff...))

end

end

```

Кроме собственно генерации полиномов, неплохо бы иметь возможность производить с ними арифметические действия.

Поскольку в Julia арифметические операторы — это обычные функции, к которым в качестве синтаксического сахара добавлена инфиксная запись (выражения `a + b` и `+(a, b)` — оба допустимы и абсолютно идентичны), то перегрузка их делается точно так же, как и написание дополнительных методов к своим функциям.

Единственный тонкий момент — пользовательский код запускается из модуля (пространства имён) `Main`, а функции стандартной библиотеки находятся в модуле `Base`, поэтому при перегрузке нужно либо импортировать модуль `Base`, либо писать полное имя функции.

Итак, добавляем сложение полинома с числом:

```

# из-за особенностей парсера Base.+ не работает,

# и нужно писать Base.:+, что означает "символ :+ из модуля Base"

function Base.:+(p::Polynomial, x::Real)

Polynomial(tuple(p.coeff[1] + x, p.coeff[2:end]...))

end

function Base.:+(p::InterpPolynomial, x::Real)

# т.к. стандартный конструктор заменён на построение интерполяции по узлам и значениям -

# при сложении с числом нужно пересчитать значения во всех узлах.

# Если операцию сложения планируется использовать часто -

# стоит добавить конструктор по узлам и коэффициентам

fval::Vector{Float64} = [evpoly(p, xval) + x for xval in p.xval]

InterpPolynomial(p.xval, fval)

end

# чтобы сложение работало в любом порядке

function Base.:+(x::Real, p::AbstractPolynomial)

return p + x

end

```

Для сложения двух обычных полиномов достаточно сложить коэффициенты, а при сложении интерполяционного полинома с другим можно найти значения суммы в нескольких точках и построить новую интерполяцию по ним.

```

function Base.:+(p1::Polynomial, p2::Polynomial)

# при сложении нужно учесть, какой должна быть наивысшая степень

deg = max(p1.degree, p2.degree)

coeff = zeros(deg+1)

coeff[1:p1.degree+1] .+= p1.coeff

coeff[1:p2.degree+1] .+= p2.coeff

Polynomial(coeff)

end

function Base.:+(p1::InterpPolynomial, p2::InterpPolynomial)

xmax = max(p1.xval..., p2.xval...)

xmin = min(p1.xval..., p2.xval...)

deg = max(p1.degree, p2.degree)

# для построения суммы строим чебышёвскую сетку между минимальным

# и максимальным из узлов обоих полиномов

xmid = 0.5 * xmax + 0.5 * xmin

dx = 0.5 * (xmax - xmin) / cos(0.5 * π / (deg + 1))

chebgrid = [xmid + dx * cos((k - 0.5) * π / (deg + 1)) for k = 1:deg+1]

fsample = [evpoly(p1, x) + evpoly(p2, x) for x in chebgrid]

InterpPolynomial(chebgrid, fsample)

end

function Base.:+(p1::InterpPolynomial, p2::Polynomial)

xmax = max(p1.xval...)

xmin = min(p1.xval...)

deg = max(p1.degree, p2.degree)

xmid = 0.5 * xmax + 0.5 * xmin

dx = 0.5 * (xmax - xmin) / cos(0.5 * π / (deg + 1))

chebgrid = [xmid + dx * cos((k - 0.5) * π / (deg + 1)) for k = 1:deg+1]

fsample = [evpoly(p1, x) + evpoly(p2, x) for x in chebgrid]

InterpPolynomial(chebgrid, fsample)

end

function Base.:+(p1::Polynomial, p2::InterpPolynomial)

p2 + p1

end

```

Таким же образом можно добавить и другие арифметические операции над полиномами, в результате получив представление их в коде в естественной математической записи.

Пока на этом всё. Постараюсь дальше написать про реализацию других численных методов.

При подготовке использованы материалы:

1. Документация языка Julia: [docs.julialang.org](https://docs.julialang.org/)

2. Площадка обсуждения языка Julia: [discourse.julialang.org](https://discourse.julialang.org/)

3. J.Stoer, W. Bulirsch. Introduction to Numerical Analysis

4. Хаб Julia: [habr.com/ru/hub/julia](https://habr.com/ru/hub/julia/)

5. Think Julia: [benlauwens.github.io/ThinkJulia.jl/latest/book.html](https://benlauwens.github.io/ThinkJulia.jl/latest/book.html) | https://habr.com/ru/post/450628/ | null | ru | null |

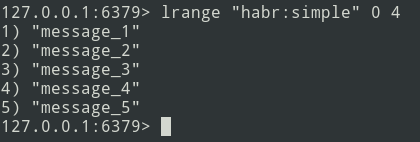

# Пишем генератор рандомных акций Мосбиржи на JavaScript

Идея появилась, после того как случайно увидел [подобный генератор для американской биржи NASDAQ](https://github.com/RayBB/random-stock-picker), где автор bash скриптом скачивает с FTP сервера сводный список американских бумаг и трансформирует его в JSON, состоящий из одних тикеров, а затем при помощи фреймворка bootstrap и чистого JavaScript выводит на экран рандомный биржевой тикер, одновременно давая ссылку на популярный ресурс Yahoo! Finance.

*«Магия» платформы CodePen для Московской биржи*

Код был адаптирован для российских реалий и помимо получения списка бумаг с Мосбиржи был сделан расчет доходности за последние n лет.

Дополнительный сервер не потребовался, потому что [API Мосбиржи](https://habr.com/post/486716/) может делать выдачу сразу в формате JSON.

Что нужно для работы генератора случайных акций?

------------------------------------------------

1. Брать информацию с биржи [о существующих «идентификаторах режима торгов» (boardid) Мосбиржи.](https://iss.moex.com/iss/engines/stock/markets/shares/boards/)

```

//информация о торгуемых акциях на Московской бирже

url = 'https://iss.moex.com/iss/engines/stock/markets/shares/boards/'

```

2. Брать [полный список бумаг для некоторых boardid на Мосбирже.](https://iss.moex.com/iss/engines/stock/markets/shares/boards/TQBR/securities.json?iss.meta=off&iss.only=securities&securities.columns=SECID,SECNAME)

```

boardid = 'TQBR' //идентификатор режима торгов

url = 'https://iss.moex.com/iss/engines/stock/markets/shares/boards/'+ boardid +'/securities.json?iss.meta=off&iss.only=securities&securities.columns=SECID,SECNAME'

```

3. Сверяться со [сводной статистикой бумаг на Московской бирже.](https://www.moex.com/ru/listing/securities.aspx)

4. Узнавать [текущую цену для конкретной ценной бумаги.](http://iss.moex.com/iss/engines/stock/markets/shares/boards/TQBR/securities.json?iss.meta=off&iss.only=securities&securities.columns=SECID,PREVADMITTEDQUOTE)

```

boardid = 'TQBR' //идентификатор режима торгов

url = 'http://iss.moex.com/iss/engines/stock/markets/shares/boards/'+ boardid +'/securities.json?iss.meta=off&iss.only=securities&securities.columns=SECID,PREVADMITTEDQUOTE'

```

5. Получать цену n лет назад на конкретную дату. Для этого в API Мосбиржи передаём boardid, SECID и дату, например:

[— boardid = TQBR

— SECID = SBER

— date = 2015-01-10](http://iss.moex.com/iss/history/engines/stock/markets/shares/boards/TQBR/securities/SBER.json?iss.meta=off&iss.only=history&history.columns=SECID,TRADEDATE,CLOSE&limit=1&from=2015-01-10).

```

boardid = 'TQBR' // идентификатор режима торгов

SECID = 'SBER' // тикер

date = '2015-01-10' // дата

url = 'http://iss.moex.com/iss/history/engines/stock/markets/shares/boards/'+ boardid +'/securities/'+ SECID +'.json?iss.meta=off&iss.only=history&history.columns=SECID,TRADEDATE,CLOSE&limit=1&from=' + date

```

6. Сравнивать вчерашнюю цену актива и цену 5 лет назад, чтобы узнать доходность.

```

curStock = 'AFKS'

dateNow = '2020-03-06'

datePre = '2015-03-06'

fetch(getCost(curStock, datePre)).then(result => {

return (result.json())

}).then(res => {

let costPre = res.history.data[0][2];

return (costPre)

}).then(costPre => {

fetch(getCost(curStock, dateNow)).then(result => {

return (result.json())

}).then(res => {

let costNow = res.history.data[0][2];

console.log(costPre);

console.log(costNow);

console.log(parseInt((costNow * 100) / costPre, 10) - 100)

})

})

function getCost(id, date) {

let url = `http://iss.moex.com/iss/history/engines/stock/markets/shares/boards/TQBR/securities/${id}.json?iss.meta=off&iss.only=history&history.columns=SECID,TRADEDATE,CLOSE&limit=1&from=${date}`

return url;

}

```

К коду не предъявлялось больших требований, важно было то, что он работает и выполняет свою задачу.

*Гифка с демонстрацией работы генератора рандомных акций Мосбиржи на JavaScript*

Почему-то API Мосбиржи выдает исторические данные только начиная с июня 2014 года, то есть не удается получить более ранние данные через запрос.

Полный код на [GitHub](https://github.com/empenoso/MOEX-Random-Picker) и [CodePen](https://codepen.io/empenoso/pen/poJmJZg).

Итог

----

Генератор случайных акций с Московской биржи работает и выдает не только случайные бумаги, но и считает доходность за настраиваемый интервал времени.

Также хочу отметить, что никак не связан с Московской биржей и использую ИСС Мосбиржи только в личных интересах.

Автор: [Михаил Шардин](https://shardin.name/).

Код: [Александр Палачёв](https://t.me/ppirks).

3 апреля 2020 г. | https://habr.com/ru/post/495324/ | null | ru | null |

# Как мы обвесили механику баллистического расчета для мобильного шутера алгоритмом компенсации сетевой задержки

Привет, я Никита Брижак, серверный разработчик из Pixonic. Сегодня я хотел бы поговорить о компенсации лагов в мобильном мультиплеере.

Про серверную лагкомпенсацию написано много статей, в том числе на русском языке. В этом нет ничего удивительного, ведь эта технология активно используется при создании многопользовательских FPS еще с конца 90-ых. Например, можно вспомнить мод QuakeWorld, прибегнувший к ней одним из первых.

Используем ее и мы в своем мобильном мультиплеерном шутере Dino Squad.

В этой статье моя цель ― не повторить то, что было написано уже тысячу раз, но рассказать, как мы внедряли лагкомпенсацию в нашу игру с учетом нашего технологического стэка и особенностей кор-геймплея.

В паре слов о нашем коре и технологиях.

Dino Squad ― сетевой мобильный PvP-шутер. Игроки управляют динозаврами, обвешанными разнообразным вооружением, и сражаются друг с другом командами 6 на 6.

И клиент, и сервер у нас на Unity. Архитектура довольно классическая для шутеров: сервер ― авторитарный, а на клиентах работает клиентское предсказание. Игровая симуляция написана с использованием in-house ECS и используется как на сервере, так и на клиенте.

Если вы впервые услышали про лагокомпенсацию, вот краткий экскурс в проблематику.

В многопользовательских FPS-играх матч, как правило, симулируется на удаленном сервере. Игроки отправляют на сервер свой инпут (информацию о нажатых клавишах), а в ответ сервер присылает им обновленное состояние игры с учетом полученных данных. При такой схеме взаимодействия задержка между нажатием на клавишу «вперед» и тем моментом, когда персонаж игрока на экране сдвинется с места, всегда будет больше пинга.

Если на локальных сетях эта задержка (в народе именуемая input lag) может быть незаметна, то при игре через интернет она создает ощущение «скольжения по льду» при управлении персонажем. Эта проблема вдвойне актуальна для мобильных сетей, где случай, когда у игрока пинг составляет 200 мс, считается еще отличным соединением. Часто пинг бывает и 350, и 500, и 1000 мс. Тогда уже играть с инпут лагом в быстрый шутер становится практически невозможно.

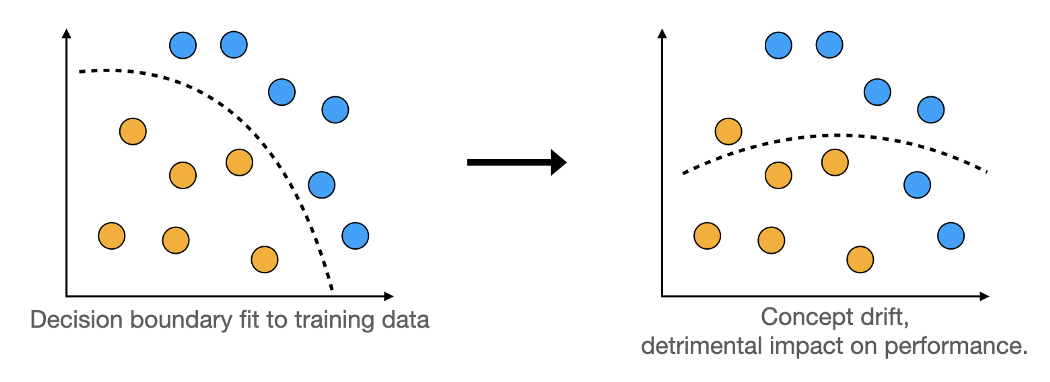

Решением этой проблемы становится предсказание симуляции на стороне клиента. Здесь клиент сам применяет инпут к персонажу игрока, не дожидаясь ответа от сервера. А когда ответ получен, просто сверяет результаты и обновляет позиции противников. Задержка между нажатием на клавишу и отображением результата на экране в этом случае минимальна.

Тут важно понимать нюанс: себя клиент всегда рисует по последнему своему инпуту, а врагов ― с сетевой задержкой, по прежнему состоянию из данных с сервера. То есть, стреляя в противника, игрок видит его в прошлом относительно себя. Подробнее про клиентское предсказание [мы писали ранее](https://habr.com/ru/company/pixonic/blog/415959/).

Таким образом клиентское предсказание решает одну проблему, но создает другую: если игрок стреляет в ту точку, где противник находился в прошлом, на сервере при выстреле в эту же точку противника в том месте может уже и не оказаться. Серверная лагкомпенсация пытается решить эту проблему. При выстреле из оружия сервер восстанавливает то состояние игры, которое видел игрок в момент выстрела локально, и проверяет, действительно ли он мог попасть в противника. Если ответ «да», попадание засчитывается, даже если противника в этой точке на сервере уже нет.

Вооружившись этими знаниями, мы начали внедрять серверную лагкомпенсацию в Dino Squad. Прежде всего предстояло понять, как вообще восстановить на сервере то, что видел клиент? И что конкретно нужно восстанавливать? В нашей игре попадания оружия и способностей рассчитываются через рейкасты и оверлапы ― то есть, через взаимодействия с физическими коллайдерами противника. Соответственно, то положение этих коллайдеров, которое «видел» игрок локально, нам и требовалось воспроизвести на сервере. На тот момент мы использовали Unity версии 2018.x. API физики там статический, физический мир существует в единственном экземпляре. Возможности сохранить его состояние, чтобы потом его восстановить из коробки, нет. Так что же делать?

Решение было на поверхности, все его элементы уже нами использовались для решения других задач:

1. Про каждого клиента нам нужно знать, в каком времени он видел противников, когда нажимал на клавиши. Мы уже писали эту информацию в пакет инпута и использовали ее для корректировки работы клиентского предсказания.

2. Нам нужно уметь хранить историю состояний игры. Именно в ней мы будем держать позиции противников (а значит, и их коллайдеров). На сервере история состояний у нас уже была, мы использовали ее для построения [дельт](https://ru.wikipedia.org/wiki/%D0%94%D0%B5%D0%BB%D1%8C%D1%82%D0%B0-%D0%BA%D0%BE%D0%B4%D0%B8%D1%80%D0%BE%D0%B2%D0%B0%D0%BD%D0%B8%D0%B5). Зная нужное время, мы легко могли бы найти нужное состояние в истории.

3. Теперь, когда у нас на руках есть состояние игры из истории, нам нужно уметь синхронизировать данные об игроках с состоянием физического мира. Существующие коллайдеры ― передвинуть, недостающие ― создать, лишние ― уничтожить. Эта логика у нас тоже уже была написана и состояла из нескольких ECS систем. Использовали мы ее для того, чтобы держать несколько игровых комнат в одном Unity-процессе. И поскольку физический мир ― один на процесс, его приходилось переиспользовать между комнатами. Перед каждым тиком симуляции мы «сбрасывали» состояние физического мира и заново инициализировали его данными для текущей комнаты, пытаясь по максимуму переиспользовать игровые объекты Unity через хитрую систему пулов. Оставалось вызвать эту же логику для игрового состояния из прошлого.

Собрав все эти элементы вместе, мы получили «машину времени», которая умела откатывать состояние физического мира до нужного момента. Код получился незамысловатый:

```

public class TimeMachine : ITimeMachine

{

//История игровых состояний

private readonly IGameStateHistory _history;

//Текущее игровое состояние на сервере

private readonly ExecutableSystem[] _systems;

//Набор систем, расставляющих коллайдеры в физическом мире

//по данным из игрового состояния

private readonly GameState _presentState;

public TimeMachine(IGameStateHistory history, GameState presentState, ExecutableSystem[] timeInitSystems)

{

_history = history;

_presentState = presentState;

_systems = timeInitSystems;

}

public GameState TravelToTime(int tick)

{

var pastState = tick == _presentState.Time ? _presentState : _history.Get(tick);

foreach (var system in _systems)

{

system.Execute(pastState);

}

return pastState;

}

}

```

Оставалось понять, как использовать эту машину для лагкомпенсации выстрелов и способностей.

В простейшем случае, когда механики построены на одиночном хитскане, вроде все понятно: перед выстрелом игрока нужно откатить физический мир до нужного состояния, сделать рейкаст, засчитать попадание или промах и вернуть мир в начальное состояние.

Но в Dino Squad таких механик очень мало! Большая часть оружия в игре создает проджектайлы ― долгоживущие пули, которые летят несколько тиков симуляции (в некоторых случаях ― десятки тиков). Как быть с ними, в каком времени они должны лететь?

В [древней статье](https://developer.valvesoftware.com/wiki/Latency_Compensating_Methods_in_Client/Server_In-game_Protocol_Design_and_Optimization) про сетевой стек Half-Life ребята из Valve задавались тем же вопросом, и их ответ был такой: лагкомпенсация проджектайлов проблематична, и лучше ее избегать.

У нас этой опции не было: оружие, основанное на проджектайлах, было ключевой особенностью игрового дизайна. Поэтому нам пришлось что-то придумывать. Немного побрейнштормив, мы сформулировали два варианта, которые нам показались рабочими:

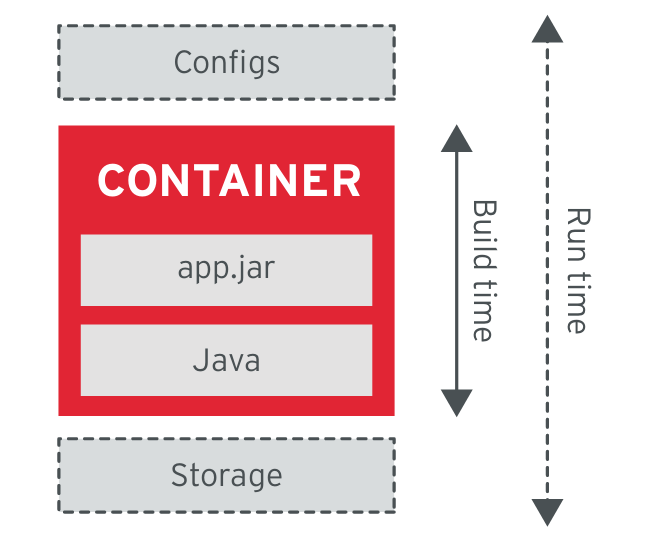

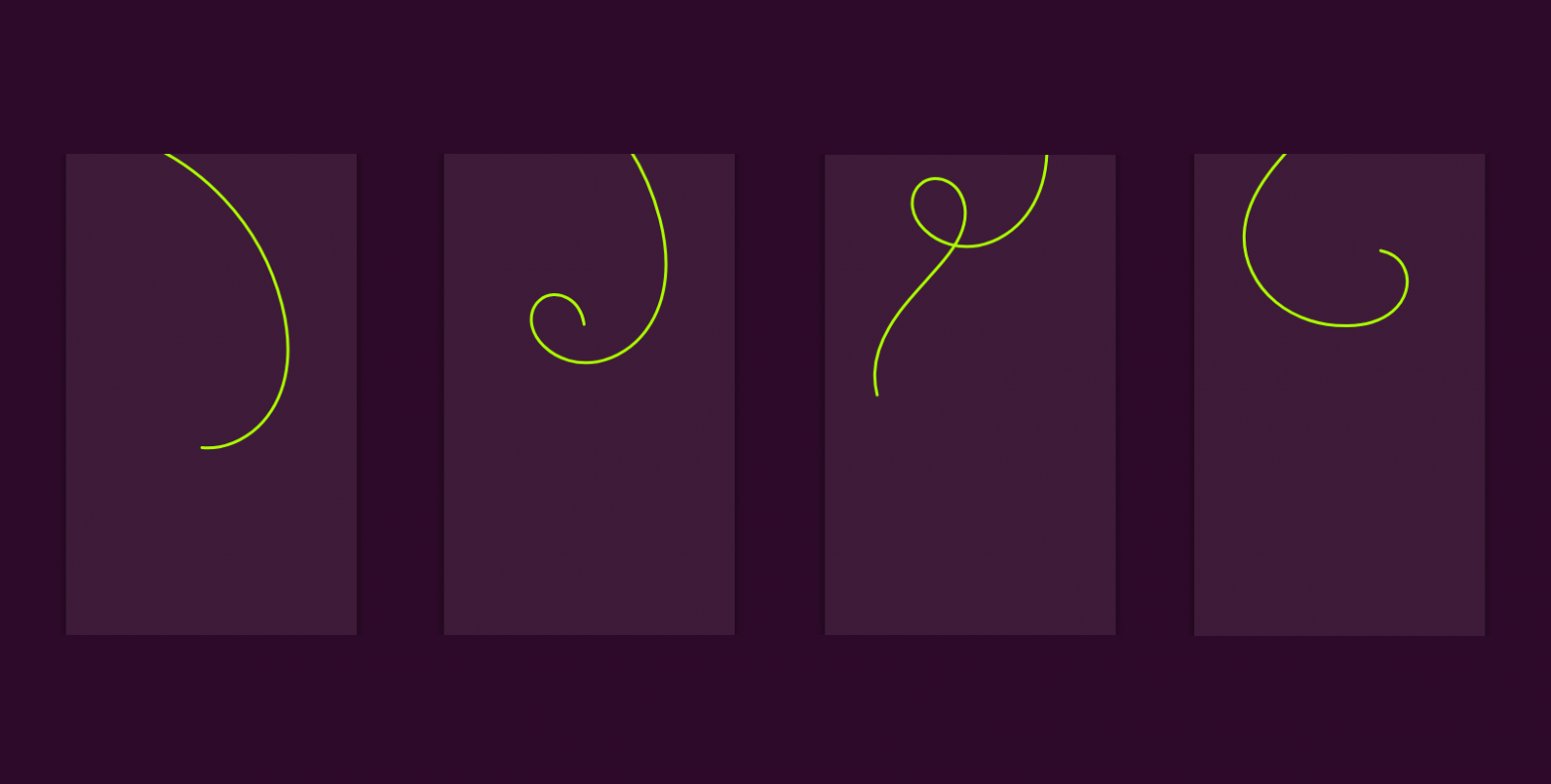

1. Мы привязываем проджектайл ко времени того игрока, который его создал. Каждый тик серверной симуляции для каждой пули каждого игрока мы откатываем физический мир до клиентского состояния и производим необходимые вычисления. Такой подход позволял иметь распределенную нагрузку на сервер и предсказуемое время полета проджектайлов. Предсказуемость для нас была особенно важна, поскольку у нас все проджектайлы, включая проджектайлы противников, предсказываются на клиенте.

*На картинке игрок в 30-ом тике стреляет ракетой на упреждение: он видит, в каком направлении бежит противник, и знает примерную скорость ракеты. Локально он видит, что попал в цель в 33-ем тике. Благодаря лагкомпенсации попадет он и на сервере*

2. Мы делаем все то же самое, что и в первом варианте, но, посчитав один тик симуляции пули, не останавливаемся, а продолжаем симулировать ее полет в рамках того же серверного тика, каждый раз приближая ее время к серверному на один тик и обновляя позиции коллайдеров. Делаем мы это до тех пор, пока не случится одно из двух:

* Срок жизни пули истек. Это означает, что вычисления окончены, мы можем засчитать промах или попадание. И это в тот же тик, в который был совершен выстрел! Для нас это было и плюсом, и минусом. Плюсом ― поскольку для стреляющего игрока это существенно уменьшало задержку между попаданием и уменьшением здоровья врага. Минусом ― поскольку такой же эффект наблюдался при стрельбе противников по игроку: противник, казалось бы, только выстрелил медленной ракетой, а урон уже засчитали.

* Пуля достигла серверного времени. В этом случае ее симуляция продолжится в следующем серверном тике уже без лагкомпенсации. Для медленных проджектайлов это теоретически могло бы сократить число «откатов» физики по сравнению с первым вариантом. В то же время возрастала неравномерность нагрузки на симуляцию: сервер то простаивал, то за один серверный тик просчитывал десяток тиков симуляции для нескольких пуль.

*Тот же сценарий, что и на предыдущей картинке, но посчитанный по второй схеме. Ракета «догнала» серверное время в том же тике, что произошел выстрел, и попадание можно засчитать уже на следующий тик. В 31-ом тике в данном случае лагкомпенсация уже не применяется*

В нашей реализации эти два подхода отличались буквально парой строчек кода, поэтому запилили мы оба, и долгое время они у нас существовали параллельно. В зависимости от механики оружия и скорости полета пули мы выбирали тот или иной вариант для каждого динозавра. Переломным моментом тут стало появление в игре механик типа «если ты попал столько-то раз по врагу за такое-то время, получи такой-то бонус». Любая механика, где время, в которое игрок попал по врагу, имело важную роль, отказывалась дружить со вторым подходом. Поэтому в итоге мы остановились на первом варианте, и сейчас он применяется для всего оружия и всех активных способностей в игре.