controlnet_IP-adapter

controlnet_IP-adapterは参照したい画像を入れると画風や人物の雰囲気などプロンプトで指定しにくい部分を模倣することができます。

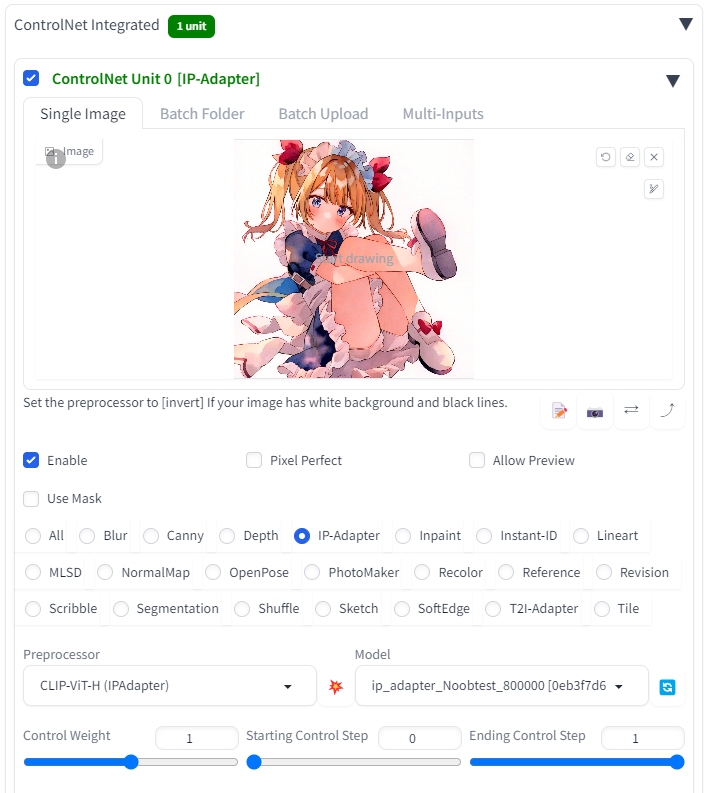

推奨モデルはnoobAIシリーズです。コントロールネットで「IP-adapter」、プリプロセッサ「CLIP-ViT-H (IPAdapter)」、modelに「ip_adapter_Noobtest_800000.bin」を選択してください。

学習不足を感じているので使い勝手は悪いかもしれません。

- 24年12月30日追記

animagineXL3.1ベースの学習モデルである「ip_adapter_test_400000.bin」も公開しました。推奨はanimagineXLシリーズです。

コントロールネットでの使用例はNoobAI使用時と変わりません。

作例

参考設定例

学習の詳細

- 全学習共通

使用機材:RTX A6000(48GB)

学習時間:408時間(約17日間)

バッチサイズ:2

学習解像度1024

学習第一段階

ベースIP-adapterモデル:ip-adapter_sdxl.bin(https://huggingface.co/h94/IP-Adapter)

ベースcheckpoint:animagineXL3.1

トレーニング枚数:5万枚

学習率:1e-4(一定)

学習ステップ:40万ステップ

学習第二段階

ベースIP-adapterモデル:ip-adapter_animegineXL-400000.bin(24年12月30日公開)

ベースモデル:NoobAI 1.1

トレーニング枚数:5万枚(途中から反転画像を加え10万枚に)

学習率:1e-7(一定)

学習ステップ:40万ステップ

学習第三段階

ベースIP-adapterモデル:ip-adapter_noobAI_XL-400000.bin(非公開)

ベースモデル:NoobAI 1.1

トレーニング枚数:10万枚(一部に前回のデータセットを含む・反転画像なし)

学習率:6e-5(1%ウォームアップ付きコサイン曲線・終端1.2e-5)

学習ステップ:40万ステップ

備考

SDXL_baseで学習されたIP-adapterモデルはanimagineXL3.1では1e-4という比較的高い学習率でも発散することなく学習できた。

しかし、学習第二段階でNoobAIをもとに学習すると高い学習率では早々に発散が発生した。

そこで、一度低い学習率でトレーニングを行い徐々にNoobAIに適応するよう学習を行った。

学習第三段階でよりNoobAIにフィットするよう学習率を上げた。コサイン曲線を導入したが必要性は薄いと思われる。

謝辞

最後にこの学習に多くのアドバイスをくださった天紗愛氏(https://x.com/Ai_tensa) にこの場を借りてお礼申し上げます。