Marsilia-Embeddings-FR-Base 🚀

Introduction 🌟

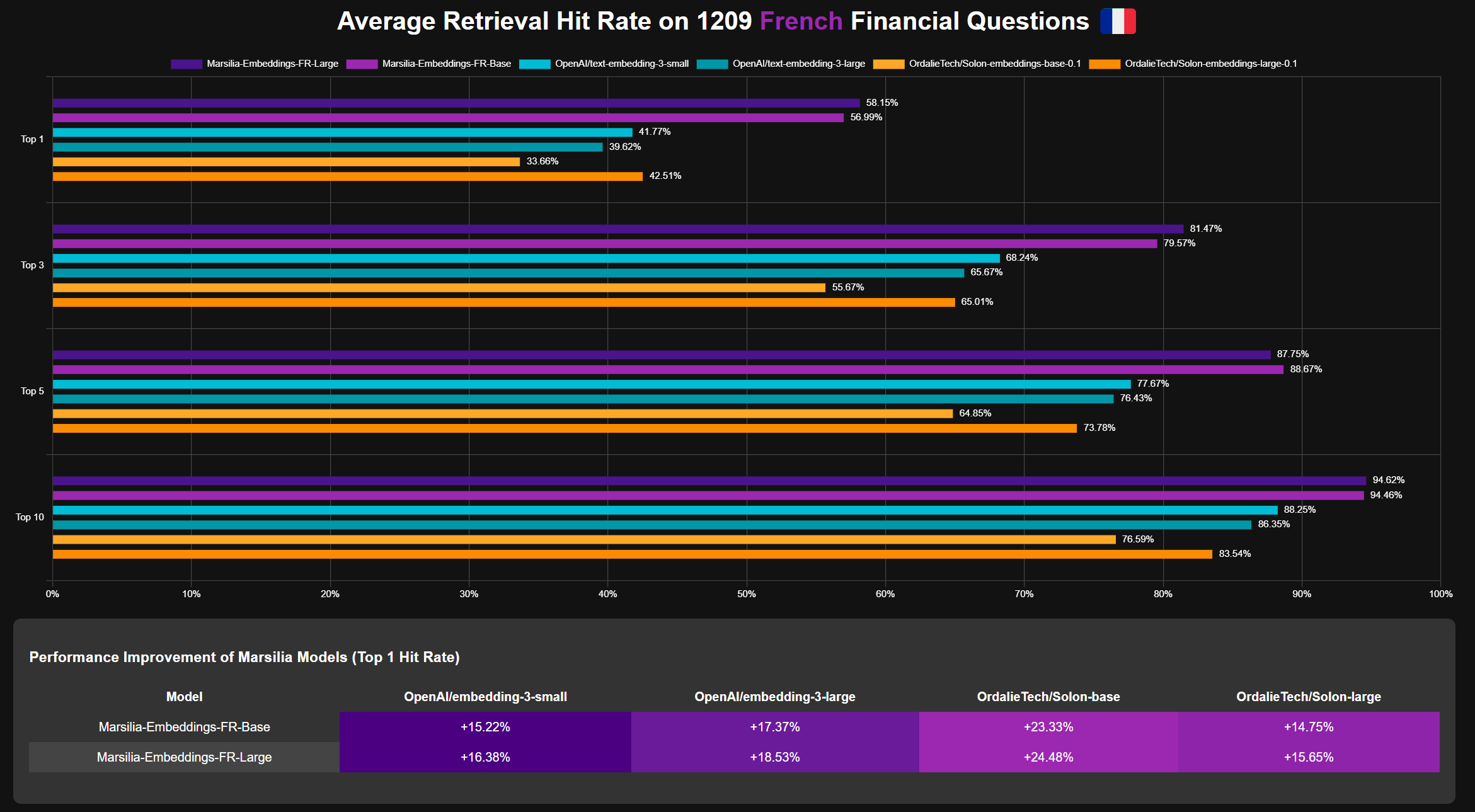

Marsilia-Embeddings-FR-Base is a French language embedding model specifically designed for financial domain tasks. This model serves as a proof of concept, demonstrating the critical importance of fine-tuning embedding models for specific tasks in Retrieval-Augmented Generation (RAG) applications.

By focusing on the financial domain, Marsilia-Embeddings-FR-Base achieves performance that surpasses even closed-source models like OpenAI's embeddings, while offering a more cost-effective solution. This showcases how targeted fine-tuning can dramatically enhance the capabilities of open-source models, making them competitive with or even superior to proprietary alternatives in specialized domains.

Model Details 📊

- Model Type: Sentence Transformer

- Language: French 🇫🇷

- Base Model: OrdalieTech/Solon-embeddings-base-0.1

- Maximum Sequence Length: 512 tokens

- Output Dimensionality: 768

- Similarity Function: Cosine Similarity

Usage 💻

To use this model with the Sentence Transformers library:

from sentence_transformers import SentenceTransformer

# Download from the 🤗 Hub

model = SentenceTransformer("sujet-ai/Marsilia-Embeddings-FR-Base")

# Run inference

sentences = [

"Comment les décisions du HCSF et du CERS peuvent-elles influencer les stratégies d'investissement des institutions financières ?",

'Les analyses menées par le HCSF pour la France l'ont conduit à juger les risques faibles et à décider de ne pas activer de coussin contra -cyclique dédié pour ces expositions45. À l'issue de son analyse concernant les pays tiers matériels pour l'Union européenne, le CERS, qui assure la coordination des actions macroprudentielles en Europe, n'a pas recommandé la fixation de taux de coussin contra -cyclique pour les pays tiers. 41 Décision n°D -HCSF -2022 -6 du 27 décembre 2022 r elative au taux du coussin de fonds propres contra -cyclique . 42 Articles 138 et 139 CRD 43 Recommandation du Comit é europ éen du risque syst émique du 11 décembre 2015 sur la reconnaissance et la fixation des taux de coussin contra -cyclique applicables aux expositions à des pays tiers (CERS/2015/1), recommandation B2. 44 En effet, l'art. 139 de CRD dispose que les autorités désignées peuvent adopter un taux de CCyB applicable aux établissements domestiques sur les expositions aux pays tiers dè s lors qu'aucun taux n'a été fixé ou que le taux fixé par l'autorité du pays tiers est jugé insuffisant. 45 Le suivi des risques est réalisé par le CERS quand les pays sont identifiés comme importants au niveau de l'Union européenne.',

'RAPPORT ANNUEL 2023 Haut Conseil de stabilité financière 18 L'encours des dépôts bancaires des SNF est ainsi passé de 689 Md€ fin 2019 à 913 Md€ fin 2022, tandis que la trésorerie totale des SNF est passée de 817 Md€ au T4 2019 à 1 077 Md€ au T4 2022, représentant un peu plus de 50 % de la dette totale des SNF. Pour autant, rapportée au produit intérieur brut (PIB) ou aux résultats des entreprises27, la dynamique de la dette brute des SNF apparaît davantage contenue par rapport au niveau pré -crise. À fin 2022 , l'encours de dette brute consolidée des SNF représentait ainsi 4,8 fois l e résultat annuel des entreprises, contre 4,2 fin 2019 , tandis que la dette brute consolidée des SNF représentait 80,8 % du PIB à fin 2022, contre 73 % à fin 2019. La dette nette consolidée, rapportée au PIB ou mesurée en années de résultats des entreprises, est quant à elle restée stable en 2022, et demeure comparable à sa moyenne sur la période 2010 -2021 (Graphique 18). 27 Mesurés par l' excédent brut d' exploitation (EBE). Graphique 16 – Demande et accès des PME au crédit de trésorerie (%) Graphique 17 – Flux annuels de dette et tréso rerie des entreprises sur la période 2019 - 2022 (Md€) Source : Banque de France. Dernier point : T1 2023. Note de lecture : au T1 2023, 4,8 % des PME interrogées avaient indiqué avoir demandé un crédit de trésorerie et 95,6 % d'entre elles ont obtenu plus de 75 % du montant demandé. Source : Banque de France.',

]

embeddings = model.encode(sentences)

print(embeddings.shape)

# [3, 768]

# Get the similarity scores for the embeddings

similarities = model.similarity(embeddings, embeddings)

print(similarities.shape)

# [3, 3]

Intended Use 🎯

This model is designed for generating sentence embeddings for French text, particularly in the financial domain. It can be used for various natural language processing tasks such as semantic search, clustering, and information retrieval.

Training Data 📚

The model was fine-tuned on the sujet-ai/Sujet-Financial-RAG-FR-Dataset. This dataset consists of question-context pairs in French, focusing on financial topics.

- Training Set Size: 28,880 samples

Training Procedure 🛠️

Training Hyperparameters

- Loss Function: MultipleNegativesRankingLoss

- Scale: 20.0

- Similarity Function: Cosine Similarity

- Evaluation Strategy: Steps

- Per Device Train Batch Size: 100

- Per Device Eval Batch Size: 100

- Number of Train Epochs: 10

- Batch Sampler: no_duplicates

- Multi Dataset Batch Sampler: round_robin

- Scheduler: Warmup cosine

Framework Versions

- Python: 3.10.13

- Sentence Transformers: 3.0.1

- Transformers: 4.42.3

- PyTorch: 2.5.0.dev20240704+cu124

- Accelerate: 0.32.1

- Datasets: 2.20.0

- Tokenizers: 0.19.1

Evaluation 📈

The model was evaluated using the InformationRetrievalEvaluator on the test split of the sujet-ai/Sujet-Financial-RAG-FR-Dataset.

Limitations ⚠️

The model is specifically trained on French financial texts and may not perform optimally on other domains or languages. Users should be aware of potential biases present in the training data.

Citation 📄

If you use this model in your research or applications, please cite:

@software{Marsilia-Embeddings-FR-Base,

author = {Sujet AI, Allaa Boutaleb, Hamed Rahimi},

title = {Marsilia-Embeddings-FR-Base: A fine-tuned French embedding model for financial texts},

year = {2024},

url = {https://huggingface.co/sujet-ai/Marsilia-Embeddings-FR-Base}

}

Contact Information 📧

For questions, feedback, or collaborations, please reach out to us on LinkedIn or visit our website https://sujet.ai.

- Downloads last month

- 1,513